执行摘要

当前的大型语言模型(LLM)与通用人工智能(AGI)之间存在着一个根本性的"创造性"鸿沟。这一鸿沟并非简单的技术迭代或规模扩展所能弥合,而是源于两者在认知机制、知识表示和创新能力上的本质差异。

LLM本质上是基于海量数据进行统计预测的复杂模式匹配机器,其能力严格局限于训练数据所定义的"知识流形"内,无法进行真正的范式创新或科学发现。 因此,通往AGI的道路必然需要超越现有LLM框架的理论和架构创新,而非仅仅依赖于规模的扩张。

1. 核心论点:LLM与AGI的根本性"创造性"鸿沟

维沙尔·米斯拉教授的核心观点

哥伦比亚大学计算机科学教授维沙尔·米斯拉提出了一个深刻的观点:尽管LLM在模式匹配和文本生成方面表现出色,但它们本质上无法像人类一样进行真正的科学发现和理论创新。

"LLM无法创造新的范式。它们只能在已有的知识框架内进行推理和组合,而无法跳脱这个框架,创造出全新的科学范式或理论。"

— 维沙尔·米斯拉教授

LLM的局限性

- 无法进行范式转移和理论创新

- 局限于训练数据定义的知识流形

- 缺乏真正的科学发现能力

真正的AGI特征

- 能够进行科学发现和理论创新

- 具备抽象思考和假设验证能力

- 能够进行"内部心理实验"

2. 理论工具:信息论与几何流形

贝叶斯流形:LLM的知识边界

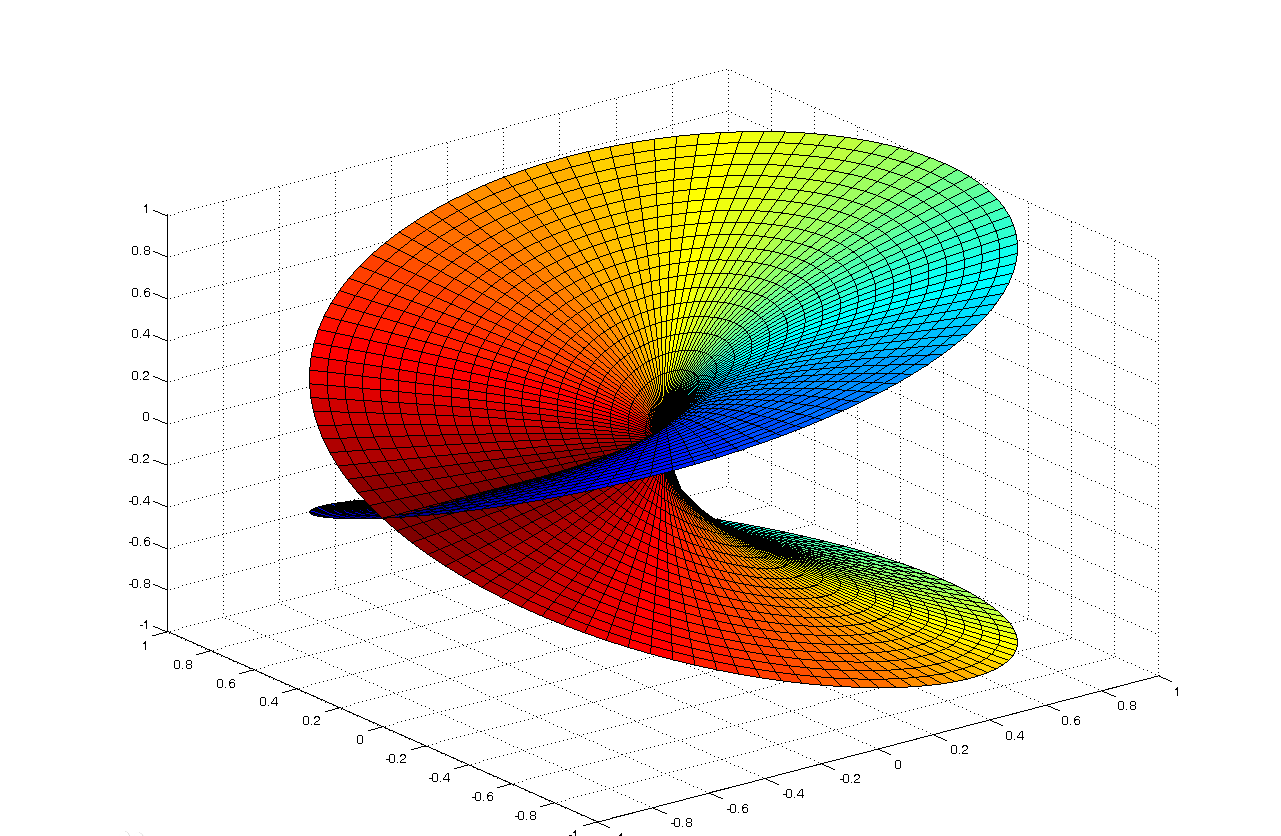

"贝叶斯流形"是米斯拉教授理论框架中的核心概念。它指的是LLM在其高维参数空间中所学习到的、由训练数据定义的概率分布结构。这个流形可以被看作是LLM的"知识世界"或"认知边界"。

流形的特征

- • 有限性:完全由训练数据决定

- • 结构性:高维空间中的几何结构

- • 封闭性:无法超出训练数据范围

"创造性鸿沟的本质,就在于LLM无法跳脱其'贝叶斯流形'进行创新。"

信息论与熵:推理机制的驱动力

矩阵模型:插值与创造的本质

LLM的数学表示

米斯拉教授将LLM概念化为一个巨大的稀疏矩阵,其中每一行代表一个可能的提示,每一列代表一个可能的词元。

归纳闭包原则

LLM的输出是其训练数据的一个"归纳闭包",所有可能的、由训练数据通过有限次归纳推理所能得出的结论的集合。

3. LLM的内在机制与能力边界

核心能力:模式匹配与预测

模式匹配优势

- 强大的统计相关性识别能力

- 高效的文本生成和处理

- 多语言理解和翻译

根本性局限

- 缺乏真正的理解和抽象推理

- 无法像人类一样迁移知识

- "幻觉"问题:生成与事实不符的内容

根本性局限

缺乏持久记忆

当前LLM大多是"无状态"的,缺乏对过去交互的持久记忆和长期目标设定能力。

无法自我改进

LLM从根本上无法进行递归自我改进,因为训练数据是静态的、由人类提供的。

缺乏物理直觉

知识完全来源于文本数据,缺乏对物理世界的直接感知和"具身认知"。

4. 通往AGI的路径:超越LLM的新理论与新架构

新的数学框架

代数拓扑与信息拓扑

通过同调论分析神经网络中的信息流动,使用"信息环"和"同调容量"等新概念理解推理本质。

信息几何与Kolmogorov复杂性

通过分析概率分布的几何特性量化创造力,使用Kolmogorov复杂性衡量信息的新颖度,构建能够自主评估和优化创造力的AGI系统。

新的AGI架构

递归-扩散-连贯(RDC)架构

递归(Recursive)

模拟大脑皮层的层次化结构,递归处理不同抽象层次的信息

扩散(Diffusion)

模拟神经信号扩散,促进不同模块间的协同工作

连贯(Coherence)

确保系统内部信息保持一致性和连贯性

混合系统与载体流形

将符号逻辑和神经网络相结合,以取长补短。符号逻辑擅长处理离散的、结构化的知识,而神经网络则擅长处理连续的、非结构化的数据。

载体流形:知识编码在神经元群体的活动模式所构成的几何流形中,更好地解释大脑如何处理复杂的高维信息。

AGI的核心能力

代理(Agency)

自主设定目标、制定计划并采取行动的能力

适应性(Adaptivity)

通过经验重塑策略,不断学习和调整行为

预测(Prediction)

建模环境并选择行动,进行因果推理

创造力(Creativity)

进行类比推理与概念构建,实现范式创新

5. 结论与展望

LLM并非通往AGI的终点

当前的大型语言模型(LLM)并非通往通用人工智能(AGI)的终点,而更像是一个强大的、但能力有限的"里程碑"。

规模扩张无法弥补创造性鸿沟。无论模型有多大,训练数据有多丰富,只要其核心架构不变,LLM就永远被困在由过去数据所定义的概率世界中。

多学科融合

AGI的实现离不开数学、计算机科学、认知科学和神经科学等领域的深度交叉融合。

范式转变

从统计学习到因果推理的转变,构建能够进行反事实推理和干预分析的AI系统。

安全可信

构建可解释、可验证、安全的AGI系统,确保AI的发展符合人类福祉。

深度思考

"通往AGI的道路需要突破当前LLM的架构,发展出能够进行模拟和假设的新模型。这不仅是技术问题,更是对人类智能本质的深刻理解和重新思考。"

— 基于维沙尔·米斯拉教授的理论框架