GLM-5:

开源Agentic Engineering的新纪元

7440亿参数的稀疏MoE架构,DeepSeek注意力机制,

以及异步强化学习框架Slime的技术突破

架构创新

效率突破

性能表现

模型概述与核心定位

从"Vibe Coding"到"Agentic Engineering"的范式转变

Vibe Coding 局限性

- • 依赖模型直觉的轻量级开发

- • 局部代码片段生成

- • 缺乏系统性理解能力

- • 无法处理复杂项目端到端

Agentic Engineering 优势

- • 自主规划与多步骤执行

- • 长期记忆保持

- • 持续学习与环境适应

- • 完整软件工程生命周期

这一范式转变的技术驱动力源于GLM-5在三个维度的突破:预训练规模的显著扩展(总参数量从355B提升至744B,预训练数据从23T增至28.5T tokens)为模型提供了更丰富的知识储备;DeepSeek稀疏注意力机制(DSA)的引入使得模型在保持长上下文建模能力的同时大幅降低了计算成本;最关键的是Slime异步强化学习框架与新型智能体RL算法的部署,使模型能够从复杂、长周期的交互中持续学习优化[389] [413]。

开源SOTA定位与市场竞争格局

| 维度 | GLM-5 | 主要竞品 | 差异化特征 |

|---|---|---|---|

| 总参数量 | 744B | DeepSeek-V3.2: 685B; MiniMax-M2.5: 230B | 开源最大规模 |

| 激活参数 | 40B/44B | DeepSeek-V3.2: 37B; GPT-4o: ~80B(估计) | 稀疏效率优化 |

| 上下文窗口 | 202K | DeepSeek-V3.2: 128K; Claude-3.5: 200K | 长Agent任务支持 |

| 开源许可 | MIT | Llama: 分层许可; Qwen: 有限商用 | 完全开放 |

| 训练算力 | 华为昇腾 | 主流: NVIDIA GPU | 国产自主可控 |

基础规格参数

模型架构创新

GLM-5 架构概览

202K tokens"] --> B["嵌入层

Embedding Layer"] B --> C["前3层稠密FFN

Dense FeedForward"] C --> D["MoE层 1-75

256 Experts, 8 Active"] D --> E["DSA注意力

DeepSeek Sparse Attention"] E --> F["MTP多Token预测

Multi-Token Prediction"] F --> G["输出层

Output Layer"] H["Lightning Indexer"] --> E I["稀疏选择

Top-2048"] --> E style A fill:#e1f5fe style B fill:#f3e5f5 style C fill:#e8f5e8 style D fill:#fff3e0 style E fill:#fce4ec style F fill:#e0f2f1 style G fill:#f1f8e9 style H fill:#efebe9 style I fill:#efebe9

混合专家架构(MoE)

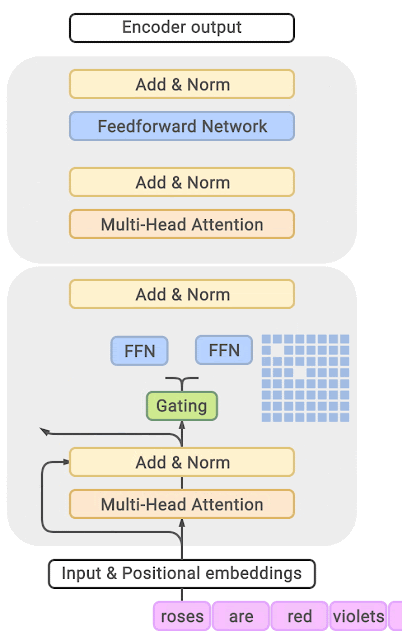

DeepSeek稀疏注意力机制(DSA)

核心设计目标

DSA的核心目标是将自注意力机制的计算复杂度从序列长度的平方级O(L²)降至线性或近线性级别。对于128K tokens的上下文,全注意力需要计算约82亿个注意力对,而DSA通过选择性稀疏化,将有效计算压缩至约2.6亿对,压缩比达97% [34]。

Lightning Indexer

- 轻量级评分组件,快速扫描历史token相关性

- ReLU激活函数替代Softmax,计算效率提升

- 固定Top-k=2048稀疏选择策略

两阶段计算流程

多Token预测(MTP)

提升生成效率的辅助机制

MTP的核心思想是在每个解码步骤中并行预测多个未来token,而非传统的单token自回归生成。这一机制可以显著降低生成延迟,尤其在需要长文本输出的场景中。

与DSA的协同优化

- • 稀疏注意力降低计算开销

- • 更多计算预算分配给MTP

- • 延迟降低补偿两阶段计算开销

推测解码策略

- • 每次预测1个额外token

- • 基于验证的生成机制

- • 推理框架深度优化

训练方法与基础设施

预训练策略

Slime异步强化学习框架

核心创新:生成与训练的解耦架构

Slime是GLM-5训练方法中最具原创性的技术贡献,被官方描述为"新型异步强化学习基础设施"[9] [30]。其命名"Slime"(史莱姆)暗示了系统的灵活性与适应性。

异步架构优势

- GPU利用率接近100%,消除同步等待

- 重要性采样校正,避免分布偏移问题

- 支持更大模型规模及更复杂RL任务

智能体RL算法

- 长程任务自动分解机制

- 跨步骤奖励归因与信用分配

- 轨迹回放与延迟奖励分配

Slime异步RL架构

性能表现与基准测试

学术基准测试

编程能力

工具推理

Agent任务

工程实现与部署优化

Token效率优化

DSA实际收益量化

硬件适配与可扩展性

华为昇腾

摩尔线程

寒武纪

昆仑芯

部署成本优势

通过这些优化,GLM-5在国产芯片集群上实现了"高吞吐、低延迟的稳定运行",与双GPU国际集群的部署成本相比"减半" [51]。

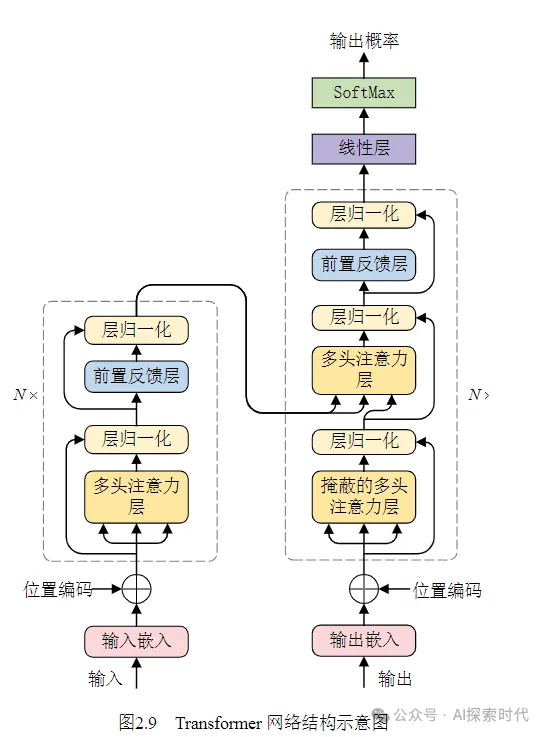

技术演进与架构溯源

DeepSeek-V3/V3.2架构继承

GLM-5对DeepSeek-V3/V3.2架构的继承,是理解其技术路线选择的关键。代码审查确认,GLM-5的DSA实现直接继承自DeepSeek的代码库[6] [34]。

相对GLM-4.7的架构升级

GLM系列技术演进路径

355B参数"] --> B["技术积累"] B --> C["GLM-5

744B参数"] A --> D["MoE架构"] A --> E["代码能力"] A --> F["长上下文"] D --> G["256专家MoE

稀疏度5.9%"] E --> H["Slime异步RL

Agentic Engineering"] F --> I["DSA注意力

202K上下文"] J["DeepSeek-V3.2"] --> K["DSA技术迁移"] K --> I C --> L["开源SOTA

全球#4"] style A fill:#e1f5fe style B fill:#f3e5f5 style C fill:#e8f5e8 style D fill:#fff3e0 style E fill:#fce4ec style F fill:#e0f2f1 style G fill:#f1f8e9 style H fill:#efebe9 style I fill:#e8eaf6 style J fill:#fff8e1 style K fill:#f3e5f5 style L fill:#e8f5e8

研究局限与未来方向

官方技术细节的披露程度

当前对GLM-5的技术理解受限于信息披露的不完整性。关键未公开细节包括DSA中Lightning Indexer的网络结构、Slime框架的异步通信协议、预训练数据的详细构成等。

技术突破方向

超长上下文泛化

固定k=2048的瓶颈突破,层次化索引设计

多智能体协同

角色分工、通信协议、群体智能系统

持续学习适应

灾难性遗忘缓解,终身学习机制

应用场景拓展

GLM-5 未来研究方向展望

| 研究方向 | 技术挑战 | 潜在突破 |

|---|---|---|

| 超长上下文(>1M tokens)DSA泛化 | 固定k=2048的瓶颈、层次化索引设计 | 自适应稀疏策略、递归注意力 |

| 多智能体协同工程 | 角色分工、通信协议、冲突解决 | 分布式Agent系统、群体智能 |

| 持续学习与终身适应 | 灾难性遗忘、稳定性-可塑性权衡 | 模块化架构、元学习、神经可塑性 |

| 多模态能力的深度整合 | 跨模态对齐、统一表征空间 | 原生多模态架构、端到端训练 |

GLM-5 里程碑意义

标志着开源大模型在"Agentic Engineering"领域的重要里程碑,为后续研究提供有价值的参考