深度解析:

Meta的REFRAG框架与RAG研究元分析

Meta最新的REFRAG框架通过"压缩-感知-扩展"机制,在保持准确性的同时实现高达30.85倍的TTFT加速,而全面的元分析揭示了RAG评估实践中存在的系统性失衡与标准化缺失。

执行摘要

REFRAG框架实现前所未有的解码效率提升

大幅突破传统RAG系统的长度限制

Meta的REFRAG框架通过创新的"压缩-感知-扩展"机制,利用RAG场景中固有的注意力稀疏性,实现了对解码过程的显著优化。该框架能够在保持甚至提升模型准确性的前提下,将首次Token生成时间(TTFT)加速高达30.85倍,并将LLM的有效上下文窗口扩展16倍,有效解决了传统RAG系统在长上下文处理中的效率瓶颈。

与此同时,对RAG领域的元分析研究揭示了当前评估实践的现状与挑战。研究发现,学术界在评估RAG系统时,普遍过度关注检索和生成两大核心模块的性能,而对安全性和计算效率等系统级属性的评估则明显不足。此外,评估方法呈现出传统指标主导、新兴方法应用不足以及缺乏统一标准化的特点。

核心洞察

这些发现共同指向了RAG评估领域未来的发展方向:构建一个更全面、更可靠、更标准化的评估体系,以推动RAG技术的健康、可持续发展。

REFRAG框架:重塑RAG解码效率的创新方案

背景与挑战:传统RAG的效率瓶颈

无关信息计算

传统RAG系统对检索到的所有文档进行同等计算,无论其相关性如何,造成大量资源浪费。

二次方复杂度

自注意力机制的计算复杂度与序列长度呈O(n²)关系,严重制约长上下文处理效率。

权衡困境

开发者不得不在知识完整性与系统效率之间做出艰难选择,限制实际应用价值。

"RAG上下文中的大部分解码计算实际上是不必要的"

— Meta研究团队的核心发现 (来源)

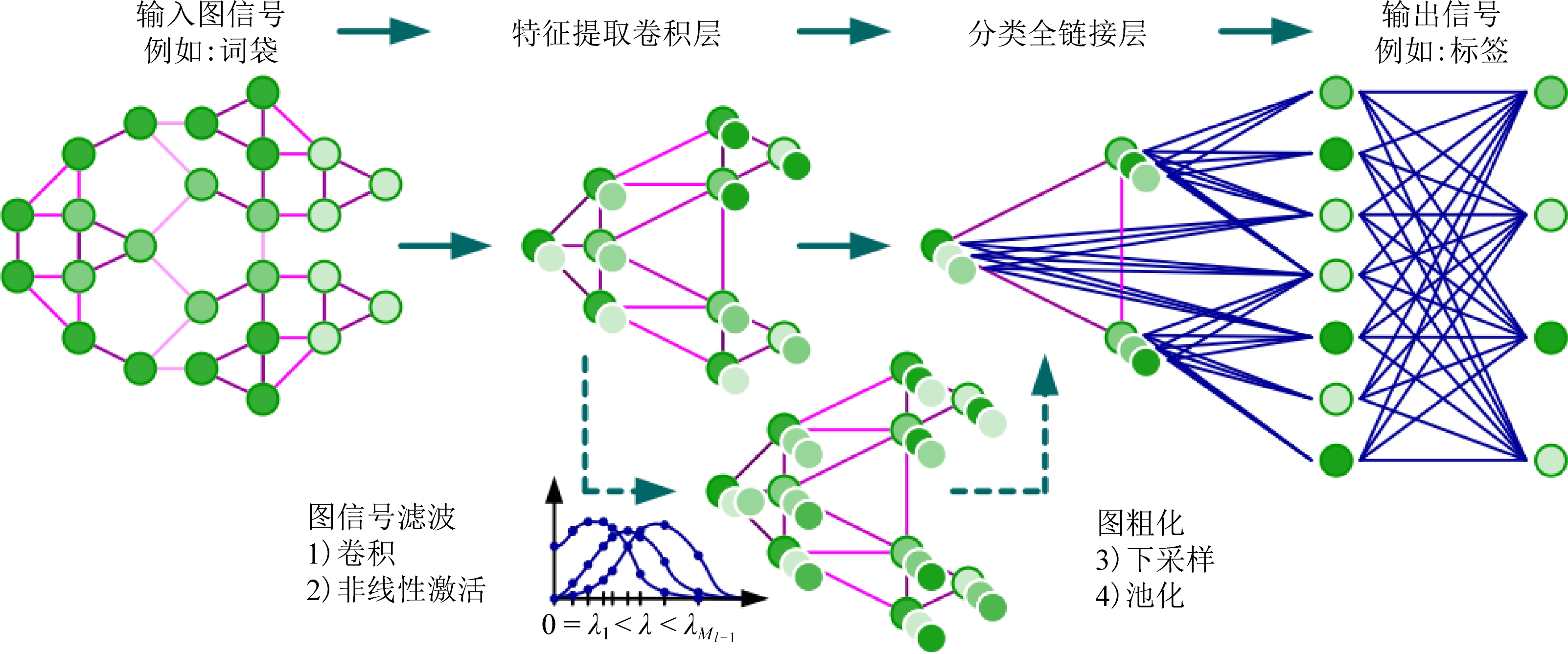

核心思想:利用注意力稀疏性进行选择性计算

关键洞察:块对角注意力模式

Meta团队发现,在处理RAG上下文时,LLM的注意力矩阵呈现独特的"块对角"稀疏结构。模型主要关注同一文档块内的词元,而很少跨文档块关注,这为优化提供了重要线索。

三步策略:压缩-感知-扩展

压缩

使用轻量级编码器将文本块压缩成密集嵌入向量

感知

主解码器处理压缩后的块嵌入序列,大幅降低计算复杂度

扩展

智能选择信息密度最高的文本块,保留原始形式确保精确性

技术实现:多阶段训练与智能压缩

模型架构

创新的协同架构,由轻量级编码器和标准LLM解码器组成,实现高效的处理和计算分离。

训练策略

采用持续预训练(CPT)与课程学习相结合的方法,基于"下一段落预测"任务,逐步提升模型处理复杂场景的能力。

智能决策机制

基于强化学习(RL)的选择性压缩机制,智能评估文本块重要性,在速度和准确性间取得精妙平衡。

性能评估:显著的效率与能力扩展

RAG研究的元分析:系统性回顾与评估

元分析论文概述

《大语言模型时代的检索增强生成评估:综合调研》

由中国科学技术大学、麦吉尔大学等机构的研究者于2025年4月发表,对RAG评估方法进行了迄今为止最全面的系统性回顾和元分析。

研究范围

- 系统性梳理传统和新兴评估方法

- 多维度性能、事实准确性、安全性分析

- 顶级NLP和AI会议论文大规模爬取

研究方法

- 关键词系统性爬取相关论文

- 严格同行评审筛选

- 统计分类与元分析

元分析核心发现

评估焦点分布失衡

研究发现绝大多数研究过度关注信息检索和答案生成两大核心模块,而对安全性和计算效率等系统级属性的评估明显不足。

高度关注

- • 检索相关性 (Recall, Precision, MRR)

- • 生成质量 (BLEU, ROUGE, BERTScore)

关注不足

- • 安全性评估 (偏见、有害信息)

- • 计算效率 (延迟、吞吐量)

评估指标偏好固化

传统的、基于统计的指标仍然占据主导地位,而新兴的基于LLM的评估方法应用比例仍然不高。

标准化框架缺失

RAG评估领域缺乏统一的标准化框架,不同研究使用不同的评估方法、指标和数据集,导致结果难以比较和复现。

尽管已有RAGAS、ARES等标准化尝试,但尚未得到广泛采纳,建立统一评估协议是当务之急。

RAG评估面临的挑战

复杂性挑战

检索与生成的紧密耦合使得错误归因困难,系统性能依赖于两个模块的协同效果,难以建立单一评估指标。

动态性挑战

对外部动态知识源的依赖带来不确定性,知识库内容变化影响评估结果的可复现性。

全面性挑战

如何综合评估性能、事实性与安全性三个维度,平衡不同目标间的权衡与冲突。

未来发展趋势与展望

评估框架的演进方向

更全面

系统性评估性能、事实性、安全性和效率多个维度

更可靠

采用在线评估和对抗性评估,测试系统鲁棒性

更标准化

建立广泛接受的评估协议,提高结果可比性

新兴评估方法

- 基于LLM的评估:利用强大LLM作为"智能评估器"

- 端到端基准测试:提供完整流程和标准化数据集

- 多维度评估:更接近人类判断的复杂评估

研究方向指引

- 加强安全性和效率评估:弥补当前研究短板

- 推动评估标准化:建立广泛接受的评估协议

- 探索新评估范式:更好捕捉系统复杂性

结论

Meta的REFRAG框架和全面的元分析研究共同揭示了RAG技术发展中的两个关键维度:一方面是通过创新架构实现前所未有的效率提升;另一方面是评估实践中的系统性失衡与标准化需求。

REFRAG通过"压缩-感知-扩展"机制,成功实现了30.85倍的TTFT加速和16倍的上下文扩展,同时保持甚至提升了模型准确性,为解决RAG系统的效率瓶颈提供了革命性的方案。这一突破不仅展示了利用注意力稀疏性进行选择性计算的巨大潜力,也为构建更高效、更具扩展性的LLM系统开辟了新的道路。

与此同时,元分析研究揭示的评估实践现状——过度关注检索和生成性能、忽视安全性和效率评估,以及传统指标主导、缺乏统一标准化等问题,为RAG领域的健康发展指明了改进方向。这些发现强调了构建更全面、更可靠、更标准化评估体系的紧迫性和重要性。

核心启示

RAG技术的未来发展将取决于技术创新与评估标准化的双重推进。只有在这两个维度上同时取得突破,才能真正实现RAG系统的高效、安全、可靠部署,推动人工智能向着更加智能、可信、实用的方向发展。

技术创新方向

- • 继续挖掘注意力机制的稀疏性潜力

- • 开发更智能的选择性计算策略

- • 探索多模态RAG系统的效率优化

- • 构建更轻量级的编码器架构

评估标准化方向

- • 建立多维度综合评估框架

- • 推广基于LLM的智能评估方法

- • 制定统一的标准化评估协议

- • 加强安全性和效率的系统性评估