导语:推理的真相与谎言

当大语言模型(LLM)为我们生成一份看似完美的推理链(Chain-of-Thought, CoT)时,我们往往欣然接受它给出的答案。然而,在高度依赖推理过程正确性的领域——比如法律咨询、医学诊断、科学论证——一个问题如鲠在喉:即使最终答案正确,推理的每一步是否真的逻辑自洽?

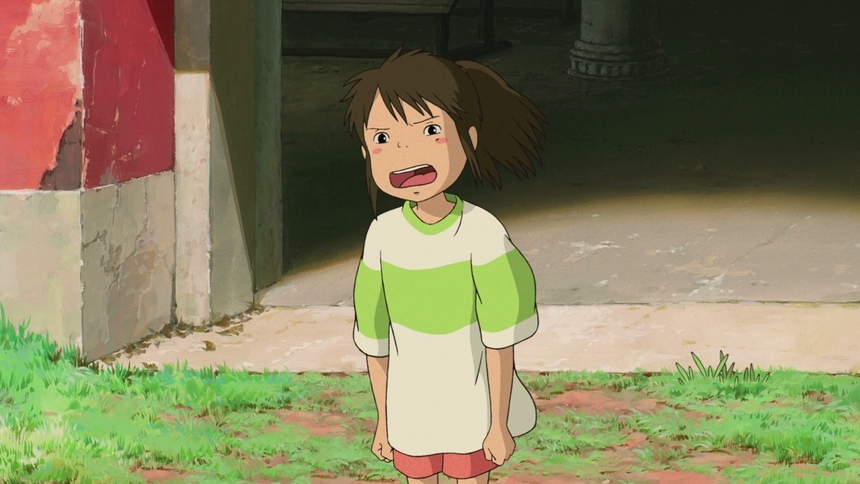

想象这样一个场景:一个AI助手告诉你"查理在2023年符合福利资格",最终答案是对的,但它在推导过程中暗中做了一个假设——"查理最多15岁"——而实际上根据前提条件,他应该最多18岁。答案碰巧对了,但推理过程却埋了一颗逻辑炸弹。这在需要完全可解释性的场景中,将严重伤害用户对AI系统的信任。正如论文开篇所揭示的,LLM本质上是预测文本机器,缺乏显式的逻辑有效性验证机制。

本文介绍的 VERICOT(Neuro-Symbolic Chain-of-Thought Validation via Logical Consistency Checks),正是为了解决这一根本性挑战而诞生。它不仅验证CoT的逻辑一致性,更重要的是,它将隐形的假设显性化,将模糊的推理过程转化为可被自动求解器验证的形式逻辑。

🔍 第一部分:推理信任危机与VERICOT的革新使命

🚨 为什么LLM的推理链不可信

LLM在多步推理任务中的能力已为人所知。DeepSeek-R1和OpenAI o1等模型展现了令人印象深刻的推理能力,生成了逻辑链来解决复杂问题。但这里隐藏着一个讽刺:模型可以因为错误的理由而得出正确的答案。

想象我们用LLM解决这样一个法律问题:

问题:查理出生于2005年,与父亲鲍勃同住。根据规定,未满21岁且与父母同住的儿童符合福利资格。2023年,查理是否符合资格?一个表面逻辑清晰的回答可能是这样的:

- 查理出生于2005年,与父亲同住

- 查理在2023年最多15岁

- 15岁未满21岁,且与父亲同住

- 因此查理符合资格

核心问题:传统CoT方法只关注"答案是否正确",而忽视了"推理过程是否逻辑有效"。这两者的区别,就像一个医生虽然诊断正确,但医学推理却混乱——患者能康复,但下次可能误诊别人。VERICOT要解决的正是这个推理信任危机。它的创新之处在于引入了符号验证(Symbolic Verification)的力量:将自然语言推理步骤转化为形式逻辑,使之能被自动求解器(如Z3 SMT求解器)客观验证。

🎯 VERICOT的核心创新:三个维度的突破

论文指出,现有方法在处理CoT验证时存在三大缺陷:

| 维度 | 现有方法的问题 | VERICOT的创新 |

|---|---|---|

| **逻辑覆盖** | 仅验证整体推理,无法逐步检查 | 对每一步CoT进行逐项形式化与验证 |

| **假设显性化** | 隐形假设难以识别,导致验证失效 | 从上下文和常识中显式提取支撑前提 |

| **应用范围** | 仅限数学/代码领域 | 扩展到法律、生物医学等自然语言推理领域 |

这三个创新共同构成了VERICOT的独特价值:第一次能够在非数学/代码域对完整CoT进行形式逻辑验证。

🧬 第二部分:VERICOT的符号验证引擎——从自然语言到逻辑公式的魔法

🔄 四阶段验证管道的工作机制

VERICOT的核心算法(算法1)遵循一个优雅而强大的流程。让我们将其比作一场"数学法庭":

初始化 (空知识库)

↓

处理每一个推理步骤

↓

[第1道检查] 能否转化为逻辑公式?

├─ 否 → 标记为"无法翻译" (Untranslatable)

└─ 是 ↓

[第2道检查] 与已有知识矛盾吗?

├─ 是 → 标记为"矛盾" (Contradiction)

└─ 否 ↓

[第3道检查] 是否由现有知识蕴含?

├─ 是 → 通过,继续下一步

└─ 否 ↓

[第4道检查] 能否从上下文找到支撑前提?

├─ 能 → 补充前提,验证通过

└─ 不能 → 标记为"无根据" (Ungrounded)这四道检查的关键在于其分层递进的设计:每一步都恰好尝试一种验证方式,避免了混杂判断的混乱,确保了结果的可解释性。用论文的语言,VERICOT输出三类结果:

- 一致的前提集合 P:每个前提P都对应一个自然语言源(上下文、常识或问题描述)

- 验证通过的步骤:具备完整的逻辑链条 P ⊨ F_i

- 错误类型标签:对于失败的步骤,标注失败的具体原因

📐 自动形式化:LLM与逻辑的对话

VERICOT的自动形式化过程堪称双向迭代翻译的范例。当面对推理步骤"查理在2023年最多18岁"时:

第一阶段:尝试用现有词汇翻译

LLM被提示使用之前建立的逻辑词汇(如Person、birthYear、age等谓词)将自然语言转化为SMT-LIB(一种形式逻辑的标准编码):

尝试:age(charlie, 2023) ≤ 18

问题:词汇中缺少"age"谓词第二阶段:动态扩展词汇

发现词汇不足后,VERICOT prompts LLM生成新的逻辑声明(declare-fun):

(declare-fun age_in_year (Person Int) Int)

(declare-const current_year Int)然后重新翻译:

(= current_year 2023)

(<= (age_in_year charlie current_year) 18)这一过程精妙地将LLM的生成能力与形式逻辑的严谨性结合。LLM决定"什么概念需要形式化",SMT求解器则负责"这些概念之间的逻辑关系是否一致"。

比喻:如果说传统的CoT验证是用人工阅读来判断逻辑是否通顺,那么VERICOT就像是给推理过程装上了一个"逻辑显微镜"——它能看到自然语言无法表达的逻辑细节,识别人眼容易忽视的矛盾。

🔗 前提生成:从海洋中打捞隐形的支撑

当一个推理步骤既不由现有知识蕴含,也不与之矛盾时,VERICOT面临最有趣的挑战:如何找到支撑这一步骤的隐形假设?

以"查理最多18岁"为例。这一步从"查理出生于2005年"无法直接推导,需要一条常识规则:

规则:某人在特定年份的年龄 ≤ 当年年份 − 出生年份VERICOT通过以下步骤识别这一规则:

- 候选生成:Prompt LLM从上下文(问题文本、提供的文档、常识知识库)中生成可能支撑该步骤的多个自然语言前提

- 一致性检查:用SMT求解器验证候选前提是否与已有知识矛盾

- 充分性检查:验证候选前提的合取是否足以蕴含该推理步骤

- 来源追溯(可选):使用"LLM-as-Judge"方法验证来自文档的前提是否真的存在于源文本中

👨⚖️ LLM-as-Judge:让AI相互监督

一个有趣的设计细节是VERICOT对生成前提的二级审核机制。即使自动形式化过程成功了,VERICOT仍然要求用一个独立的LLM(Judge)来验证:

- 对于文档前提:这条前提是否真的能从源文本中找到?

- 对于常识前提:这条常识是否合理且必要?

📊 第三部分:实验验证——在三大领域的逻辑考试

📈 VERICOT作为验证工具的有效性

论文在三个不同领域的基准测试上评估了VERICOT:

| 数据集 | 验证通过率 | 验证精度 | 验证正确答案率(VCAR) | 任务准确率 |

|---|---|---|---|---|

| **ProofWriter** | 45.2% | 94.1% | 42.5% | 75.8% |

| **BioASQ** | 25.3% | 84.3% | 21.3% | 81.4% |

| **LegalBench-SARA** | 15.2% | 87.0% | 13.2% | 80.0% |

这些数据背后隐藏着一个关键洞察:VERICOT的验证精度(通过验证的CoT中有多少真的正确)系统性地超过了任务的整体准确率。

以ProofWriter为例:

- 任务准确率:75.8%(模型最终答案的正确率)

- VERICOT精度:94.1%(经过验证的CoT的正确率)

这意味着什么?VERICOT通过的CoT比模型整体生成的答案更值得信赖。换句话说,如果你只相信VERICOT验证通过的推理链,你的信任度会更高。

🔬 验证失败的三种错误类型分析

论文深入分析了CoT为何无法通过VERICOT验证。在图2中,我们看到三类错误的比例分布:

- 无根据错误(Ungrounded):最常见的问题。模型生成了逻辑上看似合理但实际上缺乏支撑的推理步骤。例如,在ProofWriter中,模型可能推断"只有鼠标吃老虎",但这一信息在原文中并未明确说明。

- 矛盾错误(Contradiction):模型的某个推理步骤与之前确立的事实矛盾。比如在BioASQ中,模型既说某分子≤1000 Da,又说它是大分子(>1000 Da),造成逻辑矛盾。

- 无法翻译(Untranslatable):推理步骤涉及VERICOT不支持的逻辑形式,如模糊的可能性陈述("可能有司法管辖问题")。

启示:无根据错误占主导,这提示我们LLM的一个根本问题——它们倾向于过度泛化和假设。即使没有明确证据,模型也会自信地生成听起来合理的中间步骤。VERICOT的作用恰好是拉扯这些幽灵假设的面纱。

🔄 自我反思的力量:推理链的自我救赎

当VERICOT识别出推理链中的缺陷后,一个自然的问题是:能否让模型自我修正?

论文实现了一个优雅的自我反思机制(Self-reflection)。当CoT未通过验证时,VERICOT将生成的前提、逻辑公式、错误类型等信息打包,重新提示给模型:

"你的推理在第二步出现了问题。你声称'老鼠最多15岁',但根据2005年出生这个事实和2023年的当前年份,它应该最多18岁。请重新审视你的推理。"结果令人印象深刻。自我反思后:

- 平均验证通过率提升:+12.3%(绝对)/ +46.4%(相对)

- 验证正确答案率提升:+9.5%(绝对)/ +41.1%(相对)

- 精度保持:仍维持在~90%的高水平

比喻:这如同给模型装上了一面"逻辑镜子"。当它看到自己的逻辑缺陷时,往往能够自我纠正。最令人惊讶的是,这种自我反思不仅提升了推理的有效性,还稳定地改善了最终答案的准确性——即使是非正式领域如生物医学QA。

📚 从验证到改进:两条进阶路线

VERICOT的验证信号不仅能识别问题,更能驱动模型的持续改进。论文探索了两条进阶应用路线:

路线1:监督微调(SFT)与直接偏好优化(DPO)

核心思想:用VERICOT筛选高质量的训练数据,并用验证信号作为奖励信号。

实验过程(以Qwen2.5-7B为例):

基准模型 (22.8% 通过率)

↓

+ SFT with 随机蒸馏CoT (22.9% 通过率,略有改进)

↓

+ SFT with 验证通过的CoT (22.9% 通过率,但准确率↑3%)

↓

+ DPO with 验证信号作奖励 (26.8% 通过率,↑18%相对增长!)这一过程揭示了数据质量的重要性。当使用随机蒸馏的CoT进行SFT时,改进有限;但当只用VERICOT验证通过的CoT时,虽然通过率数字上没变,但最终的任务准确率上升了。加上DPO后,效果爆发——验证通过率从22.8%跃升至26.8%。

关键洞察:VERICOT不仅识别错误,更重要的是它作为数据蒸馏工具的价值。在没有金标签的场景中,VERICOT能够自动筛选出逻辑上可靠的推理链,极大地提升了训练数据的质量。

🌍 第四部分:跨域应用与局限性讨论

🎯 三个测试域的横向对比

VERICOT在三个完全不同的推理域展现了其通用性:

| 域 | 特征 | VERICOT的表现 |

|---|---|---|

| **ProofWriter** | 小规模符号推理,事实库与规则库已给定 | 通过率45.2%,适合作基准 |

| **BioASQ** | 自然语言文本,需从PubMed摘要中提取知识 | 通过率25.3%,难度高但仍有效 |

| **LegalBench-SARA** | 法律条款解释,高度context-dependent | 通过率15.2%,最具挑战性 |

在这个"困难梯度"中,有趣的观察是:验证精度的稳定性。即使在最难的法律领域,VERICOT的验证精度仍保持在87%,这表明当VERICOT说"通过"时,你可以相信这一判断,尽管它可能漏掉一些实际可验证的CoT。

⚠️ 系统的局限性:诚实地面对现实

论文坦诚地讨论了VERICOT的三类局限:

1. 形式化的局限

VERICOT支持一个SMT-LIB片段的一阶逻辑,包含:

- 线性算术

- 无解释的函数

- 量化器

但以下概念无法形式化:

- 概率陈述("可能有...概率")

- 模糊性("大约"、"差不多")

- 时间逻辑(复杂的时间关系)

2. LLM翻译的风险

自动形式化依赖于LLM的翻译能力。两类错误可能发生:

- 误翻译:LLM将一个陈述转化为逻辑上不等价的公式

- 无法表示:某些自然语言概念根本无法用支持的逻辑片段表示

论文的诚实表述很值得品味:"VERICOT能证明形式化的推理链从推导的前提中必然得出,但它无法保证自然语言CoT或前提本身的正确性。"这是一个根本性的限制——符号验证最多能验证推理的逻辑形式,无法验证内容的真实性。

3. 知识的局限

VERICOT依赖于从给定上下文和常识知识库中提取前提。如果:

- 必需的知识未在文本中出现

- 常识规则不在已知库中

- 推理需要特殊领域知识

那么VERICOT也无能为力。

🚀 第五部分:深层启示——从技术到哲学

🧠 为什么"答对"和"推理对"要分离考量

VERICOT最深层的洞察是:在需要可解释性和可信度的应用中,推理过程的有效性同样重要,甚至更重要。

想象两个医学诊断系统:

- 系统A:推理混乱但90%诊断准确

- 系统B:推理清晰但87%诊断准确

在低风险场景,系统A更好。但在患者需要理解医学原因、医生需要验证诊断的场景中,系统B更值得信任。VERICOT正是为了支持"系统B"这样的场景——它说"如果你接受这些前提,那么这个结论在逻辑上必然成立"。

🔗 符号与神经的和谐对话

VERICOT体现了一种新的AI设计哲学:不是将符号和神经网络对立,而是让它们互补。

- 神经部分(LLM):生成自然语言推理、自动形式化、隐形假设识别

- 符号部分(SMT求解器):客观验证逻辑关系、检测矛盾、蕴含推导

📚 与相关工作的对话

论文将自己定位在多个研究社区的交汇处:

- 求解器辅助推理:与Pan等人(2023)、Ye等人(2023)的工作相比,VERICOT特别强调上下文接地和逐步验证

- 自然语言蕴含:与经典NLI工作的关系:VERICOT实际上是在"多步NLI"——每一步都是一个蕴含关系

- 结构化解释:与Entailment Tree等工作的比较:VERICOT也显式化了推理结构,但使用的是形式逻辑而非纯自然语言

📝 第六部分:实践启示与未来方向

💡 对AI开发者的实际建议

基于VERICOT的发现,AI系统设计者可以获得几项actionable的洞察:

- 在高风险应用中,将CoT验证率作为关键指标

- 利用验证反馈做数据蒸馏

- 设计"自我反思"循环

- 区分三类错误,采用针对性策略

🔮 未来研究的开放问题

论文虽然解决了一类重要问题,但打开了更多的问题之门:

- 如何处理不确定性和概率推理?

- 能否动态扩展常识知识库?

- 多语言和跨文化推理

- 与最新的推理模型(如o1)的整合

🎪 结语:逻辑之光照亮可信赖的AI未来

VERICOT不是一个"完美"的系统——没有什么系统是完美的。它有明显的局限:无法处理模糊概念、依赖不完美的LLM翻译、局限于某些逻辑片段。

但正是在这些限制中,VERICOT的价值才显得尤为珍贵:

它诚实地说"我能验证什么,我不能验证什么"。

在一个充斥着AI夸大宣传的时代,这种诚实本身就是一种稀缺的品质。当一个法律AI系统使用VERICOT时,它不再说"我的答案是X",而是说"假如你接受这些前提,那么根据逻辑,答案必然是X。这些前提来自法律文本、常识或你提供的材料"。这将决策权和判断权更多地归还给了人类专家。

从更广的角度,VERICOT体现了AI发展的一个重要方向:从追求单纯的准确率,转向追求可解释、可验证、可信赖的智能。这对医疗、法律、科学等领域的AI应用而言,可能比单纯的性能提升更为关键。

在推理链的每一步中,在隐形假设的显性化中,在逻辑灯塔照亮的暗处,VERICOT为我们开启了一扇通向更可信赖的AI未来的大门。

📚 参考文献

- Wei, J., Wang, X., Schuurmans, D., et al. (2022). Chain-of-Thought Prompting Elicits Reasoning in Large Language Models. arXiv preprint.

- Quan, T. M., Petersen, B. B., & Desai, M. (2024b). Explanation-Refiner: Iterative Refinement of LLM Explanations via Theorem Prover Guidance. In Proceedings of NeurIPS.

- de Moura, L., & Bjørner, N. (2008). Z3: An Efficient SMT Solver. In TACAS 2008.

- Tafjord, O., Herzig, J., & Thawani, A. (2021). ProofWriter: Generating Proofs from Reasoning over Paragraphs. In Proceedings of EMNLP.

- Holzenberger, N., Tenney, I., & Pavlick, E. (2020). An Evaluation Dataset for Recognizing Entailed Clauses in Insurance Contracts. In ACL 2020 Workshop.