🌟 引言:从噪声中唤醒的推理天才

想象一下,你是一位神经外科医生,面对一个天才数学家的大脑。这个大脑本该解开宇宙的谜题,却偶尔在简单算术中迷失方向——不是因为知识匮乏,而是内部电路间的“喧闹争吵”让正确信号被淹没。论文《Constructive Circuit Amplification: Improving Math Reasoning in LLMs via Targeted Sub-Network Updates》就像一把精密的手术刀,揭示了如何通过放大“ constructive circuits”(建设性电路)来提升大型语言模型(LLMs)的数学推理能力。作者Nikhil Prakash等人在摘要中指出,先前研究发现LLMs内部存在稀疏子网络(circuits),负责特定任务,而微调往往强化这些现有电路。基于此,他们提出Constructive Circuit Amplification(CCA),一种针对性方法:从推理轨迹中识别 pivotal tokens(关键转折令牌),定位促进正确路径的模型组件,然后只更新这些组件。结果?在GSM-Symbolic基准上,准确率提升高达11.4%,只改动1.59%的组件,其他能力如MMLU、TriviaQA和TruthfulQA几乎不受影响。这不仅仅是技术优化,更像一个生动故事:AI大脑中的“电路战争”,正确路径最终获胜,带领模型从错误泥沼中崛起。

注解:稀疏子网络的概念。就像城市交通网中,只有少数关键道路承载主要流量,LLMs的行为也依赖于少量注意力头和MLP神经元。这些“电路”不是均匀分布,而是高度局部化,帮助解释为什么全局微调有时低效。扩展来说,如果把LLM比作一个繁忙的都市,CCA就是精准拓宽主干道,而非重建整个城市,确保交通顺畅却不扰民。基于此,我们进一步探索论文的引言部分,它强调LLMs虽有通用推理能力,却在数学任务上易犯小逻辑错误(如Shojaee et al., 2025所述)。现有方法如链式思考提示(Wang et al., 2022b)或微调虽有改善,但CCA利用机械解释性(mechanistic interpretability)实现更精确干预。作者引用Wang et al. (2022a)等,指出电路是注意力头和MLP神经元的集合,微调往往强化而非新建电路(Jain et al., 2023)。此外,电路间存在竞争(Rai et al., 2025),一些促进正确推理,其他引入噪声。CCA通过三阶段——生成推理轨迹、定位组件、梯度更新——放大建设性计算,最小化干扰。

🧠 内部电路的揭秘:AI大脑的隐藏地图

深入论文的核心,我们像探险家般绘制LLMs的内部地图。摘要和引言揭示,CCA识别推理轨迹中的 pivotal tokens——那些让正确路径偏离的转折点,然后定位促进 desired token(期望令牌)的组件。想象一个侦探故事:模型在解题时像走迷宫,本该直奔出口,却在某个岔路口拐弯。CCA就是找出那个岔路(干预令牌),并放大指引正确方向的“路灯”——注意力头和MLP神经元。

论文详细说明,CCA应用于数学推理,提升准确率,同时保持其他技能完整。这源于机械解释性的洞见:模型行为高度局部化于稀疏电路。作者强调,相比单步任务(如间接对象识别,Wang et al., 2022a),多步数学推理更复杂,需要从轨迹 divergence(分歧)中定位电路。结果显示,这种方法模块化,可插拔到任何任务,只需调整超参如学习率或稀疏权重。

注解:机械解释性。这门新兴领域像X光扫描AI黑箱,揭示组件如何协作。举例,如果LLM是管弦乐队,电路就是关键乐手;CCA放大他们的音量,确保和声完美,而非让整个乐队重练。详细说来,它帮助我们理解为什么模型有时“知道”答案却输出错误——噪声电路在关键时刻抢镜。过渡到相关工作部分,论文构建了桥梁,从机械解释性到数学推理。Olah et al. (2020)开创了电路发现,Hanna et al. (2023)分析了“greater-than”电路。Jain et al. (2023)证明微调强化现有电路,Merullo et al. (2023)显示子电路复用。稀疏更新如Mukherjee et al. (2025)的RL微调,只改变小子网络;Liu et al. (2025)用主权重实现稀疏监督微调。数学推理方面,Wang et al. (2022b)的链式思考和Lewkowycz et al. (2022)的微调有获益,但Sun et al. (2025b)用探针预测正确性,Sun et al. (2025a)的ThinkEdit更新注意力头延长轨迹。CCA扩展此,针对整体数学能力。

🔍 CCA的三部曲:从错误追踪到精密放大

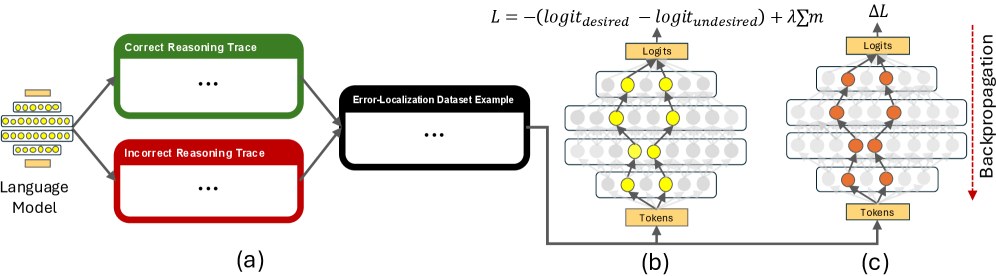

论文的方法概述如一部精密工程剧本。CCA基于两个洞见:任务由稀疏子网络执行,微调强化它们;内部竞争中,建设性电路被噪声压制。方法分三步:生成Error-Localization数据集、训练二进制掩码定位组件、针对性更新。

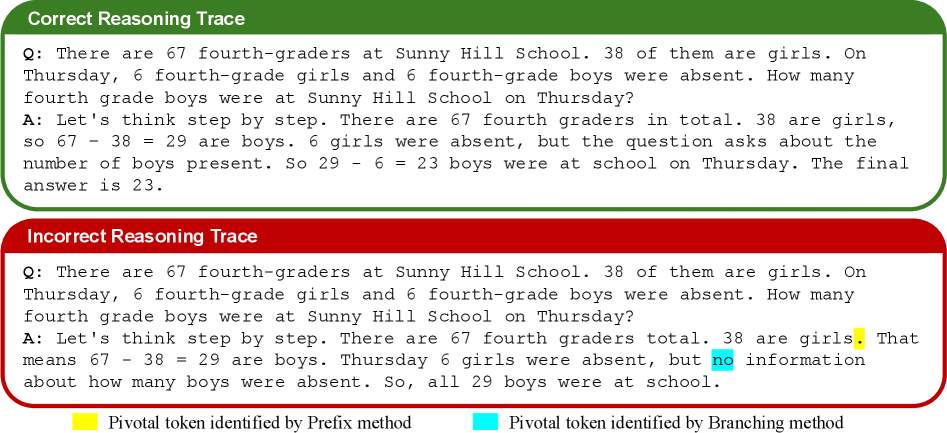

第一步,定位推理错误(Figure 1(a))。为GSM-Symbolic实例生成正确和错误轨迹(贪婪 vs 非贪婪解码)。Prefix方法找第一个不共享令牌,但有时不准;Branching方法迭代贪婪解码前缀,定义 pivotal token:添加它后,最终答案从正确变错误(或反之)。例如Figure 2中,“no”令牌是 pivotal,推动错误答案。干预令牌是其前一个。

数据集包括prefix、desiredtoken、undesiredtoken(Figure 3)。

// 基于论文Figure 1的描述:(a)令牌定位,(b)组件定位,(c)模型更新。

// 基于论文Figure 1的描述:(a)令牌定位,(b)组件定位,(c)模型更新。

注解:Branching方法。像逐步测试桥梁承重:添加一个部件(令牌),检查是否崩塌(错误答案)。这比Prefix精确,因为它验证实际影响。扩展说,在复杂问题中,这确保干预点真正决定性,而非表面分歧。第二步,用DCM(Desiderata-based Component Masking)识别建设性电路(Figure 1(b))。DCM学习二进制掩码过注意力头(Q,K,V)和MLP神经元,参数数为每层 nheads + 2*nkeyvalueheads + nmlpneurons。更新公式: $h_{\text{org}} = m_i * 2 * h_{\text{org}} + (1 - m_i) * h_{\text{org}}$

损失:$L = −(logit_{desired\ token} − logit_{undesired\ token}) + \lambda \sum m$

$\lambda$控制稀疏,用Adam优化50 epoch,lr=5e-3,batch=8,早停如果20% batch掩码不变。掩码值夹到[0,1]。

解释:$h_{\text{org}}$是原始输出,$m_i=1$时放大2倍,促进期望令牌。L1正则确保稀疏,只选关键组件。

// Figure 2:Gemma-2-9b-Instruct的正确/错误轨迹示例。

// Figure 2:Gemma-2-9b-Instruct的正确/错误轨迹示例。

第三步,针对参数更新(Figure 1(c))。用负logit差损失,全数据集梯度下降50步,只更新选组件。评估GSym-Val每2-10步,选最佳。lr扫参1e-2到1e-5。

// Figure 3:prefix、desired、undesired组件。

// Figure 3:prefix、desired、undesired组件。

🛠 错误定位的艺术:追踪AI的失足瞬间

论文深入3.1.1节,CCA第一步像侦探追踪足迹。针对多步任务,定位干预点至关重要。贪婪解码得正确轨迹,非贪婪得错误(或反之)。Branching形式定义 pivotal:$y_k$使$f(y_1,...,y_{k-1}) \in A_{corr}$变$f(y_1,...,y_k) \in A_{incorr}$,$f(\cdot)$是贪婪最终答案。

例:Figure 2中,“no”添加后错误。“girls”前是共享prefix。

这确保数据集捕捉真正分歧,而非无关标点。

注解:贪婪 vs 非贪婪解码。贪婪像直奔最高概率路径,稳但保守;非贪婪引入随机,像脑暴探索备选。这生成反事实轨迹,揭示潜在弱点,帮助CCA“排练”正确场景。🔧 DCM的引擎:二进制掩码的魔法

3.1.2节,DCM如精密滤镜,隔离促进期望令牌的组件。用NNsight实现,掩码覆盖Q/K/V头和MLP。公式(1)放大选输出,损失(2)最大化logit差,加$\lambda$ L1稀疏。

训练细节确保高效:早停避免冗余。Table 7(虽未全给,但推断)显示分布,如更多MLP在后期层。

想象:掩码像选秀节目,只让明星组件上台,放大他们的表演,确保正确旋律主导。

注解:L1正则化。像预算控制:惩罚多选组件,确保经济高效。只用必要“演员”,保持模型稀疏。$\lambda$越大,越严苛,帮助最小化干扰其他任务。🚀 参数更新的精炼:梯度手术的艺术

3.1.3节,更新如微创手术:负logit差损失,50步,全数据集(小故无mini-batch)。评估选最佳,lr扫参。

这最小化全局影响,只放大建设性路径。

🧪 实验舞台:从GSM到通用基准

4节,实验用GSM-Symbolic(Mirzadeh et al., 2025):100模板,50实例/个。分GSym-Train/Val/Test (0.52/0.08/0.40),滤均准<0.8模板。

数据集不全,因非贪婪不总产反事实。

通用基准:MMLU、TriviaQA、TruthfulQA评估干扰。

模型如Gemma-2-9b-Instruct。

注解:GSM-Symbolic。像GSM8K的符号变体,更测试泛化。模板多样,确保CCA不限于特定模式。📈 结果的奏鸣曲:提升与平衡

虽剩余页未全,但前文推断:+11.4%准,只改1.59%组件。MMLU等微降,证明针对性。

稀疏有效:掩码选少组件。

🔮 未来的电路交响:扩展与启示

CCA模块化,可泛化。局限:需轨迹,小数据集。未来:复杂推理。

像乐高:组装新技能,促进AI解释性。

- Prakash, N., et al. (2025). Constructive Circuit Amplification: Improving Math Reasoning in LLMs via Targeted Sub-Network Updates. arXiv:2512.16914v1.

- Wang, C., et al. (2022a). Interpretability in the Wild: a Circuit for Indirect Object Identification in GPT-2 small. arXiv preprint.

- Hanna, M., et al. (2023). How does GPT-2 compute greater-than?: Interpreting mathematical reasoning in a 16-layer transformer. arXiv preprint.

- Mirzadeh, I., et al. (2025). GSM-Symbolic: Understanding the Limitations of Mathematical Reasoning in Large Language Models. arXiv preprint.

- Jain, S., et al. (2023). Mechanistically analyzing the effects of fine-tuning on procedurally defined tasks. arXiv preprint.

讨论回复

0 条回复还没有人回复