现代大模型很像一块被无限放大的“皮层”:擅长统计学习、模式泛化、语言与视觉的表征压缩。但Adam Marblestone认为,AI之所以学习效率低、目标脆弱、对价值缺乏内生理解,并不主要因为架构不够大,而是因为缺少大脑里另一半更古老、更关键的系统——“转向与驱动(steering)机制”。

在他看来,人类智能不是单一学习算法的胜利,而是两套系统的协作:

一套负责建立世界模型、从经验中抽象规律(类似皮层);另一套负责把“什么重要、什么危险、什么值得追求”写进学习过程(更多来自下丘脑、脑干、基底节等皮层下结构)。AI在很大程度上只复制了前者,却把后者用简化的损失函数与外部反馈勉强替代。

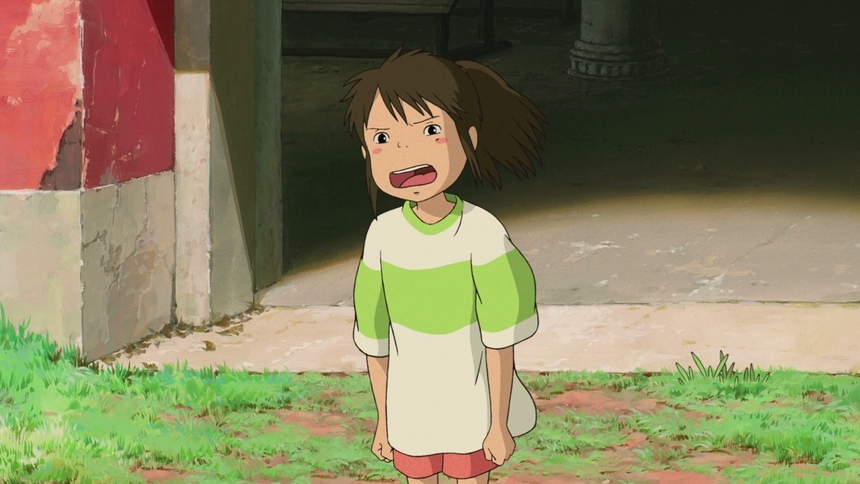

这解释了一个令人不安的对比:婴儿靠有限的生活输入就能迅速学会语言与社会规则;而LLM吞下海量文本后,仍会在常识、规划、稳定动机与价值一致性上表现出“聪明但不牢靠”的气质。

为什么孩子学语言“像呼吸”,而AI要“吞互联网”

Marblestone强调,人类幼儿并非赤手空拳地学习。进化并没有把“完整知识”写进基因,而更像写进了一套价值函数与课程编排:对面孔、眼神、语调、互动的偏好;对好奇、探索、归属、地位、羞耻与奖惩的敏感——这些不是后天学来的“知识”,而是引导学习的注意力机制与动机地形。

小贴士:这里的“价值函数”更接近“哪些情境会触发奖励/惩罚、哪些线索被系统优先当成学习信号”。它不是显式的公式,而是由遗传预设的回路与调制信号共同实现。与此相对,主流AI训练目标往往极其“计算机科学化”:例如下一词预测、或通过外部奖励做粗粒度强化学习。它能塑造强大的表征,但缺少一套内生的“何为重要”的机制,于是只能靠规模与数据密度补偿——这就像让一艘船只靠更大的发动机航行,却不装罗盘与舵。

Marblestone的核心主张:大脑的“秘密配方”在奖励/损失,而不只是结构

在Dwarkesh访谈中,他反复把问题拆解为现代机器学习熟悉的四件套:架构、学习算法、初始化、损失/奖励函数。他的“个人直觉”是:AI领域长期过度聚焦架构与规模,却低估了大脑中高度复杂、分层、阶段性启用的损失函数与奖励信号。

他甚至用一句很形象的话概括这种差异:进化像写了大量“Python代码”,为不同脑区在不同发育阶段点亮不同训练信号;而我们常用的损失函数则简单到像一行交叉熵。

更尖锐的一点是:他认为当下一些LLM式训练从强化学习角度看甚至“奇怪”——模型几乎不显式使用价值函数,而大脑里与价值估计相似的机制(例如与多巴胺相关的“奖励预测误差”)在神经科学与RL之间早已有对应关系。

解决路径:把“方向盘”做出来,而不是只把“皮层”做更大

Marblestone并不主张照搬大脑、也不迷信“解释出每个神经元在想什么”。他的路线更像是:用神经科学补齐AI缺失的关键约束与模块,把工程推进到能让理论落地的程度。

1)Connectomics:用连接组学找“先天算法”的证据

他特别强调“把大脑地图做出来”的价值:不是为了找到某个“金门大桥神经回路”,而是为了回答更底层的问题:皮层与皮层下系统如何分工?哪些回路负责生成训练信号?这些信号如何与学习到的抽象表征对接?在这一点上,FlyWire提供了一个很具象的样板:它对果蝇全脑连接组进行了长期校对与标注,规模达到约14万神经元、5000万以上突触、10万以上社区注释,并包含对突触与神经递质信息的整理,且旗舰论文已发表于 Nature(2024)。这类资源让“硬件级结构”第一次以可计算的形式进入公共视野。

2)Formalized AI:让AI发展更像“可累积的科学”

他也关心另一条更“方法论”的路线:把关键推理与验证机制形式化、可证明化,使系统能力能够像数学与工程那样累积,而非主要依赖试错与经验调参。访谈里他以Lean等形式化工具为例,强调“可验证信号”对强化学习和规模化协作的意义。3)组织形态:用FRO补足传统科研的基础设施缺口

这与他在Convergent Research的实践相呼应:Convergent自我定位为“前沿技术的任务控制中心”,通过创办时间边界明确、目标雄心勃勃的非营利“创业式科研团队”(FRO),去补齐学术界与产业界都难以稳定投入的基础设施工程。其资源页列出的项目从神经追踪平台、药物—靶点数据门户到可穿戴全脑超声接口,指向同一主题:把领域缺失的“关键工具”补起来,让整个科学树干更粗。争议与含义:这会替代“规模路线”吗?

Marblestone并不简单否定规模主义。他承认大模型的成功“令人惊讶”,只是指出:当前范式与大脑的工作方式在直觉上差异巨大,他在等待“更像大脑那样的范式”出现——例如更通用的推断形式(他讨论过“全向推断/全向预测”),以及更丰富、更分层的价值与训练信号体系。

这也把讨论推向AI安全:如果能力系统被做得极强,却缺少稳健的“steering”结构,那么对齐更像事后补丁;而若“方向盘”本身是系统的一部分,价值与学习路径可能更可控、更可解释(至少在宏观机制层面)。

讨论回复

0 条回复还没有人回复