BarraCUDA 深度

技术研究报告

探索从零构建的独立 CUDA 编译器如何突破 NVIDIA 生态垄断,实现 AMD GPU 的原生支持

执行摘要

技术突破

约15,000行C99代码实现从零构建的独立编译器,直接生成AMD RDNA 3/4机器码

性能优势

通过DPP指令优化CUDA shuffle操作,绕过LDS内存瓶颈,实现显著性能提升

生态影响

Apache-2.0开源项目为打破NVIDIA CUDA生态垄断提供技术路径

核心技术实现架构

编译器整体设计哲学

BarraCUDA代表了一种完全从零开始构建的编译器工程方法论,拒绝依赖任何现有的编译器基础设施。这一设计决策在当代GPU编译器生态中极为罕见。 [95] [96]

零外部依赖架构

除标准C库外,BarraCUDA不链接任何第三方库——既不依赖LLVM/Clang基础设施,也不使用常见工具库,甚至GPU驱动接口通过直接系统调用实现。这种设计确保了部署确定性和长期可维护性。

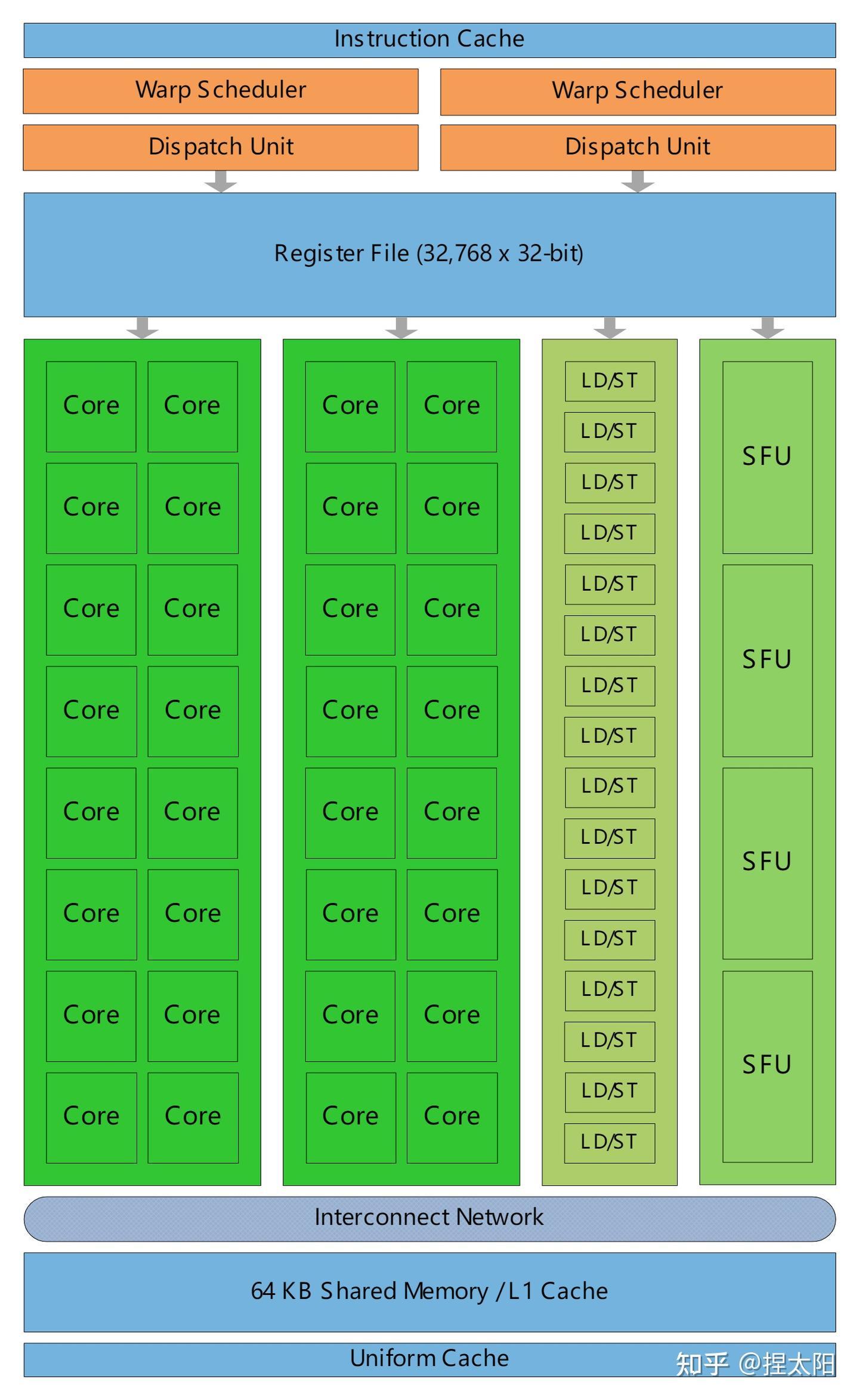

CUDA到RDNA 3机器码转换机制

性能特征与兼容性分析

关键优化突破:Shuffle操作

BarraCUDA的核心优化突破在于识别并利用AMD GPU的DPP指令集实现shuffle语义,绕过标准翻译路径的LDS内存瓶颈。

传统路径问题

- • 上游LLVM将shuffle实现为LDS访问

- • 内存访问延迟增加10-20倍

- • 额外地址计算和同步开销

- • 整体slowdown可达5-10倍

BarraCUDA优化

- • DPP指令直接寄存器交换

- • 延迟降至1-2时钟周期

- • 无需经过内存子系统

- • 3-5倍性能提升,极端情况近10倍

技术差异对比:BarraCUDA vs AMD ROCm

| 维度 | BarraCUDA | AMD ROCm (LLVM-based) |

|---|---|---|

| 编译器前端 | 自主C99实现的CUDA C++解析器 | 修改版Clang C++前端 |

| 中间表示 | BIR(专有SSA) | LLVM IR(通用表示) |

| 指令选择 | ~1,700行手写逻辑 | LLVM SelectionDAG/MachineInstr |

| 构建依赖 | 零外部依赖 | LLVM库依赖(数百MB) |

| 架构跟进 | 开发者自主控制 | 受LLVM发布周期影响 |

行业影响与战略意义

打破NVIDIA CUDA生态垄断的潜力

BarraCUDA的技术路线——完全独立的编译器实现,不依赖NVIDIA任何代码或文档——为绕过CUDA生态许可限制提供了相对"干净"的技术路径。

技术壁垒突破

绕过CUDA生态许可限制,消除代码迁移的翻译层开销,提供直接的AMD GPU支持路径

开源模式优势

Apache 2.0许可证的商业友好性,社区驱动发展模式,促进透明度和信任

市场格局影响

对NVIDIA护城河策略的潜在冲击,为其他厂商提供技术示范效应

AMD AI计算竞争力提升

软件生态短板弥补

让AMD硬件直接接入现有CUDA软件资产,加速GPU实际可用性

硬件价值释放

通过专门优化更充分利用AMD GPU硬件能力,提供最大化投资回报

市场定位重塑

增强数据中心GPU吸引力,简化开发者体验,降低迁移门槛

竞争格局演变

战略影响

- • 冲击NVIDIA CUDA垄断地位

- • 促进硬件性能、价格竞争回归

- • 为Intel、Tenstorrent等厂商提供示范

- • 推动多架构CUDA编译器发展

实际应用场景与发展前景

发展路线图与挑战

未来潜在应用方向

深度学习

框架集成、关键算子性能、分布式支持、混合精度支持

科学计算

HPC应用渐进式迁移,规则数据并行模式优化

边缘AI

零依赖紧凑设计,适合资源受限环境

讨论回复

0 条回复还没有人回复