核心洞察

- Transformer发明者Llion Jones发出"死胡同"警告

- CTM架构通过时间动态实现真正推理

- Scaling Law正在扼杀创新氧气

关键问题

核心命题:AGI之路的方向性危机

1.1.1 Transformer发明者的身份悖论

Llion Jones的身份构成了当代AI发展史上最富戏剧性的悖论。作为2017年里程碑论文《Attention Is All You Need》的八位共同作者之一,Jones不仅是Transformer架构的命名者,更是这一技术革命的核心缔造者——该论文已被引用超过10万次,成为21世纪最具影响力的计算机科学出版物之一[1]。

然而,正是这位最深谙Transformer架构的研究者,在2025年AI行业最鼎盛的时刻发出了震撼行业的自我批判:他宣布"绝对厌倦"(absolutely sick)于自己的发明,决定从2024年初开始"大幅减少在Transformer上的研究时间"[1] [2]。

1.1.2 AI鼎盛期的"死胡同"论断

现状指标

- 全球AI投资超过1500亿美元

- OpenAI估值逼近千亿美元

- GPT-4达到人类专家水平

Jones的警告

- AI已"钙化"在单一架构

- 研究人员对突破视而不见

- "利用-探索"严重失衡

Jones的"死胡同"论断发布于一个极具讽刺意味的时间节点。2024-2025年间,AI行业达到历史巅峰,但他却在此刻发出了刺耳的警告:当前AI已经"钙化"(calcified)在单一架构方法周围,可能使研究人员对下一个重大突破视而不见 [1]。

Transformer架构的深层困境

2.1 设计哲学与核心机制

并行化优势

静态性局限

2.2 "锯齿状智能"的技术根源

Transformer能力分布分析

缺乏规划能力

无法分解复杂目标为子目标序列,导致多步推理任务失败

缺乏一致性检查

无法识别自身输出的逻辑矛盾,产生自相矛盾的答案

缺乏因果理解

混淆相关性与因果性,无法进行反事实思考

CTM架构:大脑启发的范式跃迁

3.1 设计原理与生物合理性

核心创新:时间动态作为计算元素

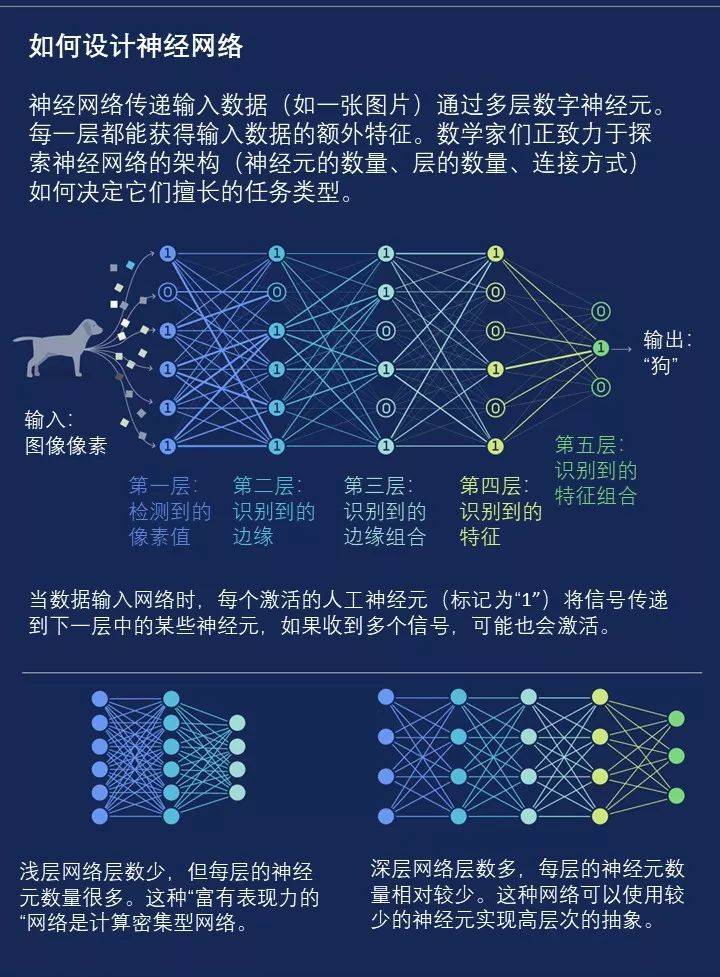

Continuous Thought Machine(CTM)的核心创新在于将时间动态重新确立为计算的基础维度,而非需要消除的序列障碍。与Transformer将时间空间化(转化为位置编码)不同,CTM引入"内部tick"(internal ticks)概念——模型拥有与数据输入解耦的内部时间维度,可在接收静态输入(如图像)或序列输入时以相同方式"思考"[7] [8]。

CTM vs Transformer 架构对比

神经元级模型(NLM)

每个NLM拥有独特的参数用于响应刺激

记忆缓冲区存储近期tick的活动

神经同步机制

γ波段同步与特征绑定相关

同步化模式作为核心表征

3.2 核心创新组件

分离的内部维度:Tick机制

CTM的"Continuous"(连续)之名源于其完全在内部"思考维度"上操作的本质。模型异步处理数据:可在接收输入后执行任意数量的内部tick,每个tick更新所有NLM的状态,而输出仅在模型决定"思考完成"后产生[7] [8]。

"当CTM被限制在少于完整迷宫追踪所需的思考时间时,它发展出一种策略——跳到可能的未来位置,向后追踪填补间隙,然后再向前跳"[9]

突触模型与U-Net通信骨干

CTM的架构包含两个核心可学习组件:突触模型(synapse model)和U-Net通信骨干。突触模型定义了神经元之间的连接动态,包括信号传递的时间特性(延迟、衰减、易化/压抑)。与Transformer的注意力权重不同,CTM的突触参数是跨tick持续存在的,支持长期依赖的形成和消退[7]。

3.3 动态推理的实现路径

自适应计算深度

简单任务快速响应,复杂任务自动延长思考过程

多步展开推理

迷宫求解可达150步,展现强大组合泛化能力

内部状态驱动

思考的中断与恢复,支持长时程推理

CTM迷宫求解过程可视化

Training"] --> B["99×99 Maze

Testing"] B --> C["6x Size Generalization"] A --> D["100 Steps

Training"] D --> E["600 Steps

Testing"] E --> F["6x Length Generalization"] style A fill:#e8f4fd style B fill:#fff2e8 style C fill:#e8f5e8 style D fill:#e8f4fd style E fill:#fff2e8 style F fill:#e8f5e8

Transformer与CTM的深度技术对比

4.1 架构设计范式差异

| 维度 | Transformer | CTM |

|---|---|---|

| 核心计算模式 | 层间并行、层内并行 | tick间串行、神经元间部分并行 |

| 时间处理 | 空间化(位置编码) | 内在化(tick序列) |

| 深度固定性 | 架构参数(层数)决定 | 运行时自适应 |

| 批处理友好性 | 极高(相同长度输入可完美批处理) | 受限(不同输入可能需要不同tick数) |

| 硬件优化 | 矩阵乘法密集,GPU/TPU高度优化 | 动态稀疏计算,需专用硬件支持 |

4.2 计算特性与效率权衡

训练并行性的丧失

推理灵活性的获取

4.3 能力边界与性能表现

图像分类任务的人类相似性优势

CTM在ImageNet-1K上的性能被报告为72.47%的top-1准确率和89.89%的top-5准确率[7],但更值得关注的是其行为特征而非原始准确率。与Transformer的视觉模型(如ViT)相比,CTM展现出"仔细移动其注视点,选择聚焦于最显著特征"的类人视觉策略[7]。

关键优势:无需温度缩放或事后调整,展现"近乎完美的校准"——预测概率与实际准确率高度一致[10]

迷宫导航的序列推理突破

迷宫求解是CTM的旗舰演示任务,在39×39迷宫、路径长度100的训练条件下,CTM成功处理99×99迷宫、路径长度约600的测试案例[7]。这种6×的规模泛化远超Transformer的典型表现。

训练条件

- • 迷宫尺寸:39×39

- • 路径长度:100步

- • 直接预测路径步骤

测试表现

- • 迷宫尺寸:99×99

- • 路径长度:约600步

- • 6倍规模泛化

行业生态与创新发展重构

5.1 研究范式的转型压力

从规模竞赛到架构创新的资源再分配

Jones的警告与行业动态共同指向资源再分配的紧迫性。当前AI研发的资源分布高度失衡:据Jones披露,70%的顶会论文集中于Transformer微调[3],架构创新研究被边缘化为"非主流"项目。

AI研究资源分布现状

开源生态催化

Sakana AI开源发布CTM代码库和模型检查点

跨学科融合

神经科学与AI的深度融合新路径

人才培养

新一代研究者在动态神经网络范式下成长

5.2 产业竞争格局的潜在演变

现有巨头的路径依赖风险

OpenAI、Google DeepMind、Anthropic等前沿实验室面临严峻的路径依赖困境。其技术栈、人才结构、商业模式都围绕Transformer扩展构建,向新架构的转型成本高昂。更微妙的是认知锁定:组织文化、领导层信念、投资者预期共同强化了"扩展即正途"的叙事。

2024年末信号:Orion、Gemini 2.0、Opus 3.5 reportedly面临性能瓶颈,原始Scaling Law可能触及"收益递减"拐点[11]

新兴力量的颠覆性窗口

CTM为新兴AI企业提供了潜在的颠覆性窗口。历史模式表明,架构代际转换是行业格局重塑的关键时机:Google凭借Transformer超越了RNN时代的先驱,OpenAI凭借扩展策略超越了学术机构。

Sakana AI优势

- • Transformer发明者技术权威性

- • 小型实验室组织灵活性

- • 东京基地的认知距离

开源策略

- • 与封闭巨头形成对比

- • 吸引全球贡献者

- • 培养早期采用者生态

5.3 创新氧气的再供给机制

多元化架构探索的激励重建

重建创新氧气需要系统性的激励机制改革。当前学术评价体系的"发表或灭亡"(publish or perish)压力,与高风险、长周期的架构创新存在根本张力。CTM的开发时间线——从概念到公开成果约两年——在AI领域已属"长期"[12]。

Jones希望CTM成为"示范案例",鼓励研究者尝试"看似风险高、但更可能通向下一个大突破的研究方向"[13]——这一愿景需要制度层面的配套改革。

长期主义研究价值

失败容忍度提升

社会文明层面的深远影响

6.1 智能本质的认知革命

从"大数据拟合"到"动态认知"的范式转换

CTM所代表的架构转向,触及了关于智能本质的深层哲学问题。当前主流AI——以Transformer为核心——可被理解为"压缩即智能"——大模型通过预测下一个token,隐式压缩了训练数据的统计规律。

CTM的"动态认知"范式则将智能重新定位于过程而非结果:关键不在于存储多少模式,而在于如何动态构建、操作和修正内部表征。这与认知科学中的"建构主义"传统——Piaget、Vygotsky等——形成呼应,强调智能作为主动的意义建构过程。

AI智能范式演进

时间维度的本体论地位

CTM将时间从实现细节提升为本体论要素,这一立场与哲学传统中的多种时间理论形成对话。伯格森的"绵延"(durée)概念强调意识的时间性不可还原为空间化测量。

生物智能边界重构

CTM的生物启发性引发了关于"生物相似性"与"智能"关系的深层问题。生物智能的某些特征(时间动态、神经同步)可能是智能的必要条件,而非可随意取舍的实现选择。

6.2 AGI发展路径的重新校准

技术乐观主义与方向怀疑主义的平衡

Jones的立场代表了AI研究中的"方向怀疑主义"声音——对当前主流路径的根本质疑。当前讨论被技术乐观主义主导:Sam Altman预测2026年AGI,Dario Amodei预测五年内半数入门级白领工作自动化[11]。

平衡关键:区分"能力扩展"与"范式转换"。承认当前路径的局部有效性,同时为其终极局限保持开放,是负责任的创新态度。

多路径探索的冗余价值

从投资组合的角度,当未来高度不确定时,分散投资比集中押注更优。AGI的实现路径存在深刻的不确定性:我们不知道Scaling Law的极限、不知道架构创新的潜力、不知道生物启发的价值。

集中化压力

- • 网络效应

- • 人才聚集

- • 规模经济

多元化价值

- • 风险分散

- • 系统性对冲

- • 创新冗余

6.3 人类主体性的存续挑战

认知外包深化

将原本由人类执行的认知任务委托给AI系统

劳动价值冲击

经济价值创造与人类劳动投入脱钩

人机协作新范式

CTM的可解释性支持真正的"混合智能"

人机协作演进路径

未来展望与战略启示

7.1 技术演进的关键变量

CTM在语言任务上的验证节点

CTM发展的最关键近期变量是语言任务上的表现验证。当前公开评估集中于视觉和强化学习领域;语言——Transformer的统治领域——将是真正的试金石。

关键问题

- • 语言建模困惑度竞争力

- • 文本连贯性和长程一致性

- • 交互式对话效率

时间线影响

- • 积极结果:快速吸引关注

- • 负面结果:边缘化风险

- • 开放策略:加速验证过程

神经形态硬件的协同进化

CTM的效率挑战可能通过硬件创新得到缓解。神经形态芯片——如Intel Loihi、IBM TrueNorth、以及各种研究原型——专为脉冲神经网络和时序动态设计,其特性与CTM的计算模式更匹配。

协同进化模式:GPU推动深度学习爆发 → Transformer优化GPU利用 → CTM需要新一代硬件 → 神经形态技术商业化

混合架构的可能性空间

最可能的近期发展并非CTM完全替代Transformer,而是混合架构的探索。Transformer在并行训练和广泛知识压缩上的优势,与CTM的动态推理和可解释性,可能通过某种形式的整合实现互补。

混合模式

- • Transformer编码器 + CTM解码器

- • CTM作为深度扩展模块

- • 任务自适应架构选择

技术挑战

- • 计算范式接口设计

- • 梯度传播稳定性

- • 训练目标协调

7.2 治理框架的前瞻构建

技术多样性保护

风险分布式承担

全球协作调节

7.3 文明级决策的紧迫性

"错误道路狂奔"的止损时点判断

Jones的警告最终指向一个文明级的决策问题:何时承认当前路径的局限性,并承担转向的成本?这一判断的困难在于:我们永远无法确定替代路径是否更优,直到它被充分验证;但等到验证完成,路径锁定可能已无法打破。

止损决策信号框架

范式转换成本评估

既有投资的沉没、技能的过时、组织的重组

长期收益潜力

新架构的能力上限、效率优势、可解释性改善

人类在智能进化中的角色定位

最终,CTM与Transformer的范式之争,折射出更深层的存在性问题:人类希望在智能进化中扮演什么角色?是被动接受技术演化的结果,还是主动塑造其方向?是将智能视为可工程化的目标函数优化问题,还是承认其内在的不可还原性?

Jones的CTM项目代表了一种主动塑造的尝试——通过生物启发的架构设计,将人类的认知特性(时间性、过程性、适应性)嵌入AI系统。这一选择,或许比任何具体的技术决策都更为根本。