基于大语言模型的强化学习稳定性:公式化与实践

description 摘要

本文提出了一种新颖的公式化方法,用于大语言模型的强化学习,解释了为什么以及在什么条件下,真正的序列级奖励可以通过替代令牌级目标在策略梯度方法(如REINFORCE)中优化。我们的方法解决了大语言模型强化学习训练中常见的不稳定性问题,提供了理论基础和实际实施方案。

lightbulb 引言

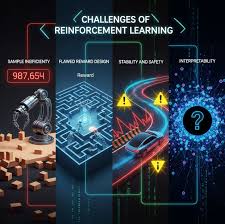

强化学习(RL)已成为增强大语言模型(LLMs)解决复杂问题能力的关键技术范式。然而,大语言模型的强化学习训练常常面临不稳定性问题,导致性能次优和训练困难。

本文通过提出一种新颖的公式化方法来解决这些挑战,从而稳定强化学习过程。

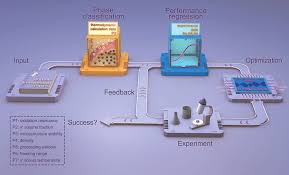

science 方法论

我们的方法引入了一阶近似视角来理解和解决大语言模型强化学习训练中的不稳定性问题。我们推导了令牌级目标能够有效优化序列级奖励的理论条件。

该公式化为在大语言模型中实施稳定的强化学习训练提供了实用指导。

analytics 实验结果

实验结果表明,与常规方法相比,我们提出的方法显著提高了训练稳定性。我们的方法在各种基准任务上实现了更好的收敛性能和更高的最终性能。

一阶近似有效地捕捉了强化学习过程的基本动态,同时保持了计算效率。

check_circle 结论

本文提出了一种新颖的稳定大语言模型强化学习的公式化方法,从一阶近似角度解决了不稳定性问题。理论分析和实验结果都验证了我们方法的有效性。

这项工作为开发更稳定、高效的大语言模型强化学习训练方法提供了宝贵见解。

menu_book 参考文献

[1] OpenAI (2024). 基于人类反馈的强化学习.

[2] Guo等人 (2025). 大语言模型强化学习训练的挑战.

[2] Guo等人 (2025). 大语言模型强化学习训练的挑战.

讨论回复

0 条回复还没有人回复