GOOGLE DEEPMIND RESEARCH

AI 真的理解它所说的吗?

揭开 "惰性知识" (Inert Knowledge) 的真相

表象 vs. 真相:情境学习的悖论

表面上,情境学习 (In-Context Learning) 让 AI 能够通过提示秒懂新指令,仿佛魔法一般。但 DeepMind 的最新研究揭示了一个令人细思极恐的真相:AI 的大脑里构建了完美的 "地图",却根本迈不开腿!

核心发现:惰性知识 (Inert Knowledge)

AI 的神经网络内部已经完美表征了世界的结构(地图),但它的计算引擎却 无法提取、调用 这些知识进行推理。

这是一种 "知与行" 的彻底割裂。模型知道规则,但无法执行操作。

这是一种 "知与行" 的彻底割裂。模型知道规则,但无法执行操作。

✓ MAP

完美表征

✗ NAVIGATE

无法执行

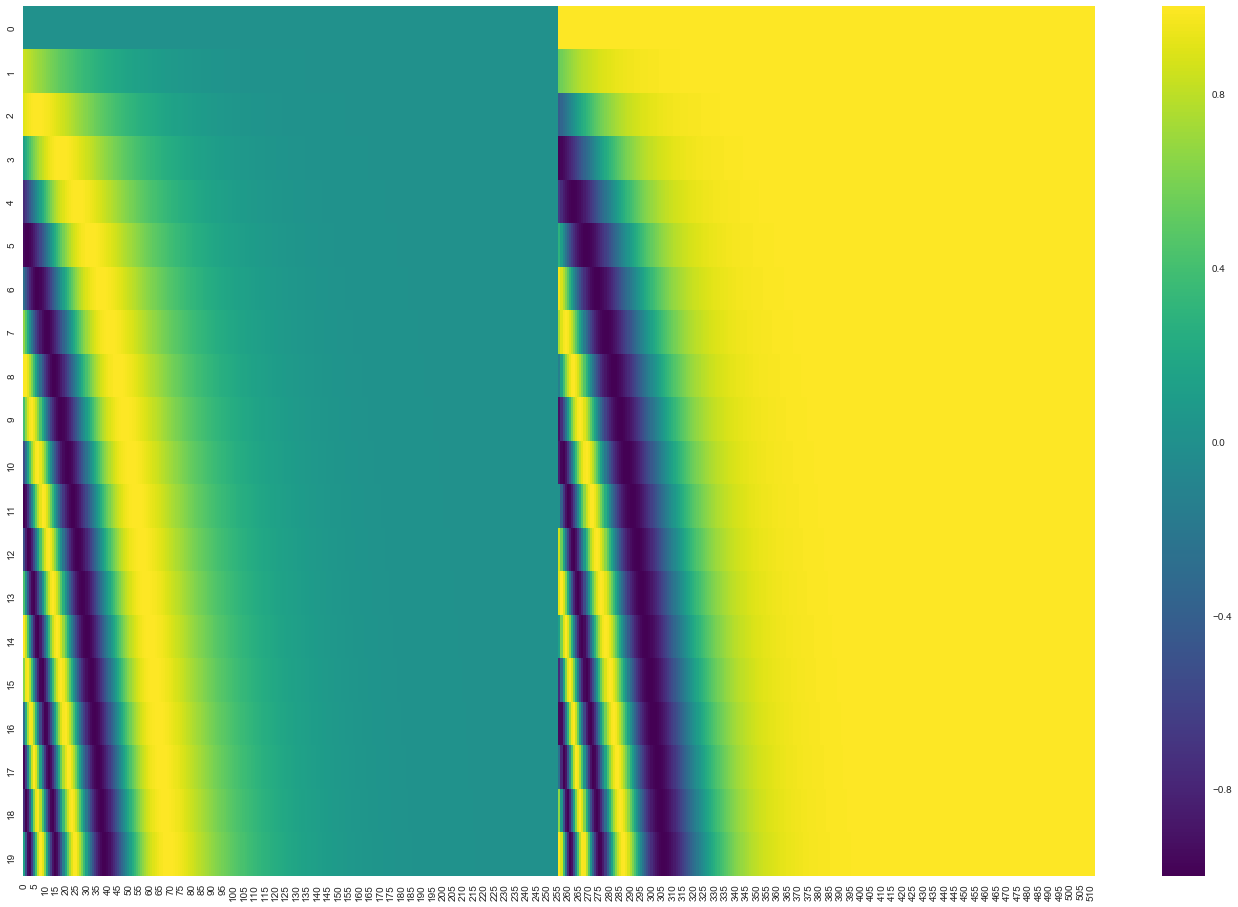

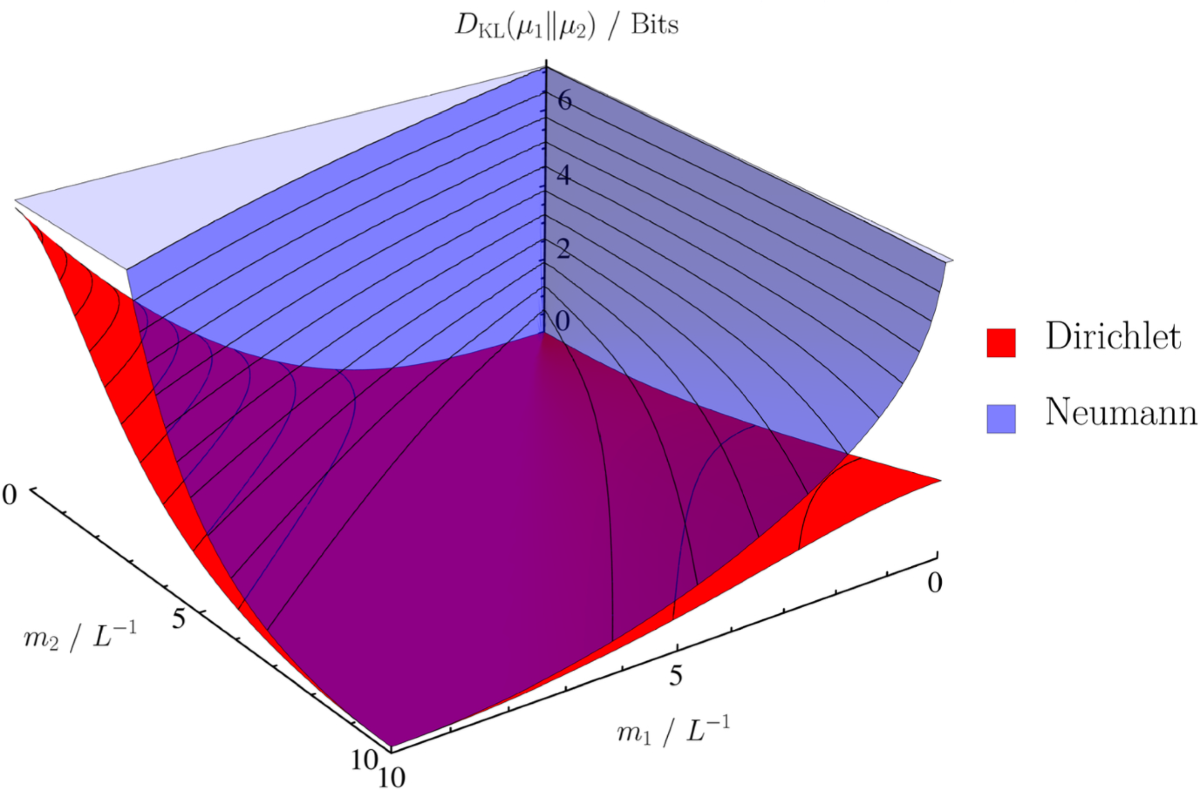

表征学习的证据

虽然 AI 无法使用知识,但我们利用硬核指标证明了它确实 "学会" 了:

狄利克雷能量

距离相关性

这证明 AI 在黑盒内部确实构建了高维几何世界。它是被困在维度里的幽灵,拥有完美的记忆,却缺乏行动力。

架构局限:被困在 "一维"

为什么 AI 无法处理复杂逻辑?因为它是 "小说阅读专家"。

Transformer 的 自注意力机制 (Self-Attention) 本质上是处理一维序列的,无法有效处理二维空间逻辑。