执行摘要

RWKV是一种创新的RNN-Transformer混合架构,通过线性注意力机制实现了O(n)的时间复杂度和O(1)的内存占用。截至2026年1月,RWKV-7-G1系列在保持同等模型质量水平的同时,相比传统Transformer架构展现出数量级的效率优势。

完全摒弃O(n²)自注意力机制,采用线性递归状态更新

RTX 4090上115+ tokens/s,显存占用低至2.4GB

特别适合长文档处理、实时交互和边缘部署场景

模型架构与技术原理

核心架构设计

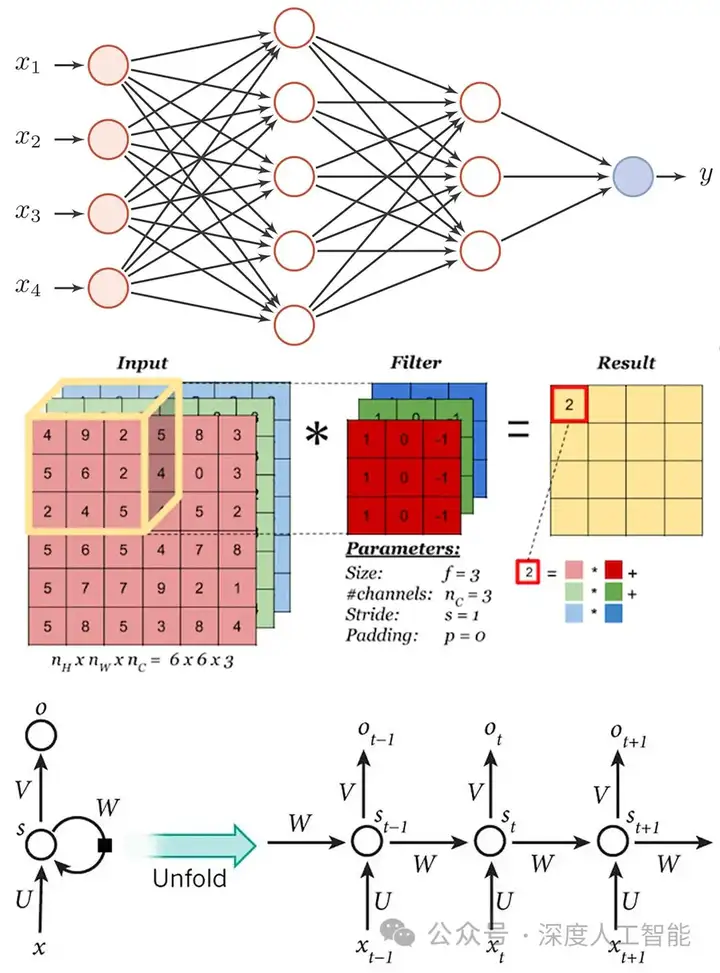

RNN-Transformer混合架构

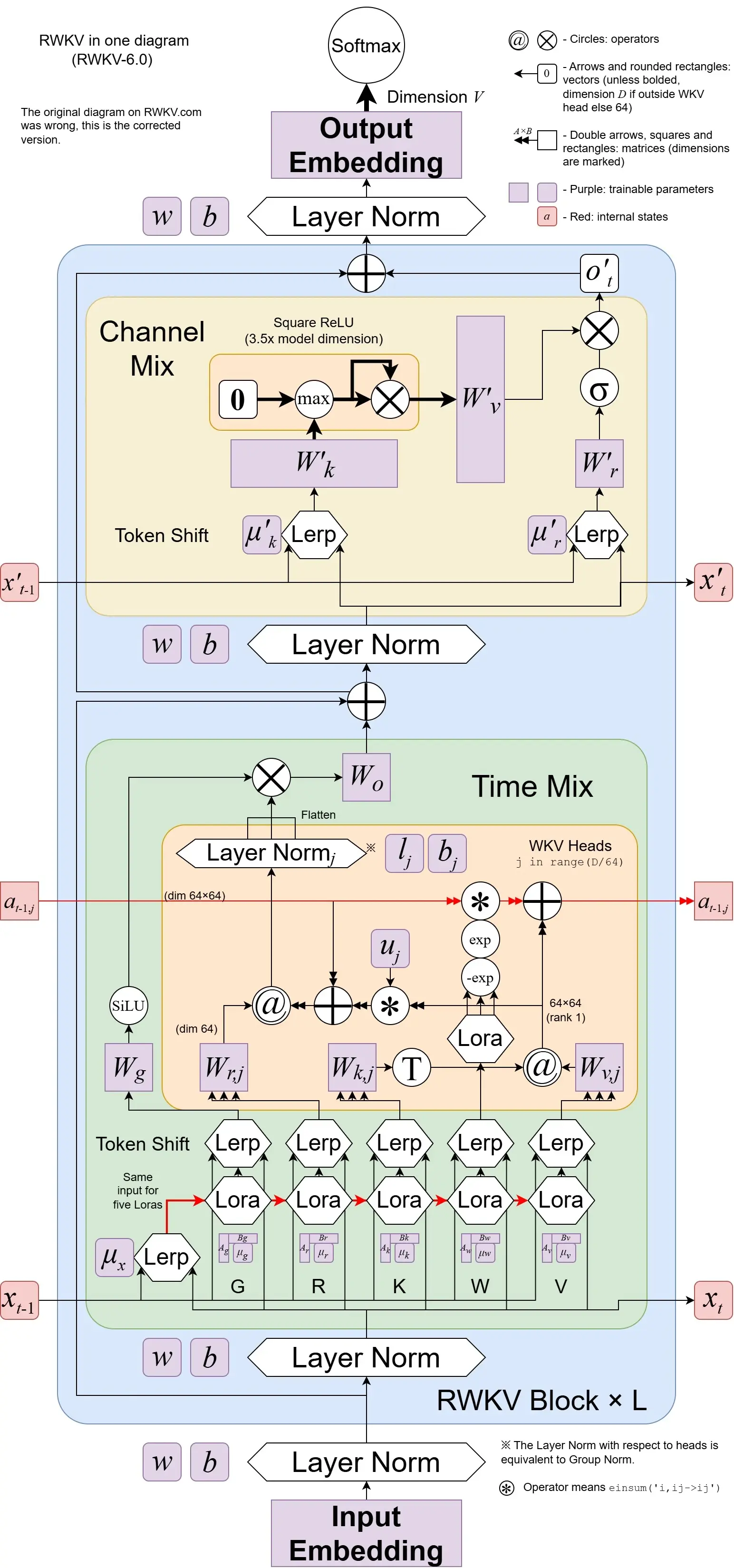

RWKV(Receptance Weighted Key Value)通过线性注意力机制替代传统多头注意力,成功融合了RNN的高效推理特性与Transformer的并行训练优势。该架构由Bo Peng及其领导的RWKV开源社区开发,自2023年加入Linux基金会以来,已发展成为备受关注的非盈利开源项目。

关键创新:完全摒弃O(n²)自注意力机制,采用递归状态更新机制,将复杂度降至O(n)线性级别

Time-Mixing Block

负责处理时序信息交互,通过RWKV机制实现历史信息的递归聚合。引入Token Shift机制增强局部上下文敏感性。

- • Receptance门控历史信息

- • Weighted时间衰减机制

- • Key-Value信息传递

Channel-Mixing Block

负责特征维度的非线性变换,功能类似Transformer的前馈网络,但完全并行化,不影响推理效率。

- • 特征空间线性变换

- • SiLU/GeLU激活函数

- • 时间步独立处理

计算效率优势

线性时间复杂度

O(n) vs Transformer的O(n²),处理10K token时效率提升可达三个数量级

常数级内存

状态内存仅400KB,与序列长度无关,相比Transformer提升超100万倍

硬件友好

规则化内存访问模式,充分利用GPU计算单元,避免内存带宽瓶颈

架构演进历程

| 版本 | 代号 | 核心创新 | 最大参数 |

|---|---|---|---|

| RWKV-4 | 基础版 | 验证混合架构可行性 | 14B |

| RWKV-5/6 | Eagle & Finch | 矩阵值状态表示 | 7B |

| RWKV-7 | Goose | 动态状态演化、广义Delta规则 | 13B |

| RWKV-7-G1 | GooseOne | 推理专用优化版本 | 2.9B-13B |

推理性能深度分析

消费级GPU性能实测

RTX 4090平台

RTX 4060 Ti 8GB

AMD RX 7900 XTX

量化技术效果分析

精度-速度-显存权衡

| 推理引擎 | 支持精度 | 平台覆盖 | 核心特点 |

|---|---|---|---|

| web-rwkv | FP16/INT8/NF4 | NVIDIA/AMD/Intel | 推荐方案,跨平台高性能 |

| llama.cpp | Q4_0-Q8_0等GGUF | 跨平台 | 生态成熟,格式丰富 |

| RWKV pip | FP16/INT8(有限) | NVIDIA (CUDA) | 官方实现,易用性高 |

| Ai00 Server | INT8/NF4 | 跨平台 | 开箱即用API服务器 |

长序列处理能力

理论无限上下文支持

RWKV采用递归状态机制而非KV缓存,处理序列的内存占用与序列长度完全无关。无论是100 token还是100万token,所需的状态内存都是固定的约400KB。

架构层面原生能力:"无限上下文"无需特殊技巧即可实现,而非通过滑动窗口等近似方法

实际部署限制

训练上下文限制

模型在特定长度上训练,超出范围性能可能衰减,但可通过微调扩展

数值稳定性

极长序列递归计算可能累积数值误差,需要特定处理策略

应用层设计

大多数应用不需要真正无限上下文,RWKV的能力更多作为安全网

性能对比(100K token)

基准测试与模型对比

标准学术基准测试

数据可用性说明

截至2026年1月,RWKV在MMLU、HellaSwag、GSM8K等标准学术基准上的公开评估数据存在显著缺口。与Llama、Mistral等主流模型不同,RWKV项目未系统发布完整的基准测试报告。

| 模型 | 参数 | MMLU | HellaSwag | GSM8K | 训练数据 |

|---|---|---|---|---|---|

| Llama-2-7B | 7B | ~45% | ~75% | ~15% | 2T tokens |

| Mistral-7B-v0.1 | 7B | ~60% | ~80% | ~37% | ~2T+ tokens |

| Llama-3-8B | 8B | ~68% | ~78% | ~46% | 15T+ tokens |

| Gemma-2-9B | 9B | ~65% | ~82% | ~50% | 6T tokens |

| RWKV-5/6 (估计) | 7B | 55-65%? | ? | ? | 2.25T tokens |

开发者报告的性能定位

RWKV官方博客报告EagleX v2(RWKV-v5,14B,2.25T tokens)"明显超过了训练了2万亿token的Llama-2-7B,并且接近Mistral-7B-v0.1和Llama-3-8B"

实际任务表现

代码生成

RWKV-7-G1系列明确强化了代码和数学能力。递归状态机制有助于维护语法结构的长期一致性。

多轮对话

恒定每步延迟确保对话长度增加时响应时间稳定,不会出现Transformer中常见的"对话越久越慢"现象。

流式生成

明确推荐用于"real-time streaming, chaining short prompts"场景,特别适合语音助手、实时翻译应用。

应用场景与部署实践

核心应用场景

长文档处理

法律合同审查、学术论文综述、金融报告摘要等需要处理数万至数十万token的场景。

实时交互系统

聊天机器人、虚拟助手等需要低延迟响应的应用场景。

边缘与端侧部署

量化后的轻量级推理需求,适合资源受限环境。

流式内容生成

连续短提示的链式处理,Agent系统、工作流自动化等应用。

模型版本选择指南

| 显存预算 | 推荐配置 | 预期性能 | 典型应用 |

|---|---|---|---|

| <4GB | RWKV7-G1-2.9B nf4 | 20-40 t/s (GPU), 可用 (CPU) | 边缘设备,轻量助手,离线处理 |

| 8GB | RWKV7-G1-2.9B int8 或 RWKV-6 7B nf4 | 60-110 t/s | 标准部署,日常对话,文档处理 |

| 16GB | RWKV-6/7 7B int8 或 14B nf4 | 40-80 t/s | 高性能应用,长文本,代码生成 |

| 24GB+ | RWKV-6/7 14B fp16/int8 | 30-60 t/s | 服务器部署,质量优先,研究用途 |

| 推理专用 | RWKV-7-G1系列 | 依配置 | 数学推理,代码生成,多步思考 |

部署工具与教程

web-rwkv引擎(推荐方案)

git clone https://github.com/cryscan/web-rwkv

cd web-rwkv && cargo build --release

llama.cpp生态

python convert-rwkv-to-gguf.py --input model.pth

./quantize model.gguf model-Q8_0.gguf Q8_0

其他部署方案

pip install rwkv,适合快速原型

开箱即用API服务器,无PyTorch依赖

容器化web-rwkv服务,配合FastAPI或Triton

竞争优势与发展展望

核心差异化优势

效率与性能平衡

重新定义效率与性能的权衡边界,在线性复杂度下仍可实现competitive的模型质量。

硬件友好性

消费级GPU上的卓越推理效率,RTX 4060 Ti即可流畅运行7B级别模型。

架构简洁性

无KV-Cache设计大幅简化推理引擎实现,核心代码可数百行内完成。

当前局限性与挑战

主要挑战领域

生态系统成熟度

微调模型、应用案例、社区规模落后于Llama/Mistral

工具链完善度

RLHF微调、多模态扩展、企业级工具待完善

基准测试透明度

缺乏系统的MMLU/HellaSwag/GSM8K公开报告

技术演进方向

RWKV-7及后续版本

动态状态演化机制为复杂推理、规划、工具使用奠定基础,能力边界持续拓展。

突破TC⁰复杂度限制

输入依赖的状态更新

多模态扩展

VisualRWKV等视觉-语言融合方向,将架构优势延伸至跨模态场景。

推理能力强化

GooseOne等专用版本的迭代,针对数学、代码、科学推理等任务深度优化。

长期愿景

RWKV的长期愿景是成为高效AI的默认选择